撰稿:陈在俊(麻省理工学院博士,现为南加州大学电子工程系助理教授)

麻省理工光计算原型机

人工智能爆炸性增长,正在改变着这个世界

如ChatGPT等生成式AI可以通过用户的想法创建新的文本、图像、视频、音乐和代码程序等,正在迅速地改变我们的生活和工作方式。人工智能是基于大量数据进行预训练的超大机器学习模型。近十年来,随着人们对AI智能程度的要求越来越高,机器学习模型的参数规模呈指数增长。目前最大的一些模型(GPT-4)已达到了上万亿参数(>1 trillion parameters)。然而,训练这些模型需要强大的计算能力(算力)、高达几个月的训练运算时间,消耗可供一个2000个家庭电力资源。计算机芯片的算力,能量效率,和规模化已成为人工智能发展的决定性因素。

谷歌、英伟达等科技公司都推出了专用于AI加速的计算芯片。然而,电子计算机的算力发展(2x/yrs)已滞后于AI模型的发展(256x/yrs)。随着晶体管尺寸正在接近单原子极限,摩尔定律将在可见的未来难于维持。光学芯片由于超高光学带宽、并行运算能力、低损耗的数据传输,有可能在短期内实现几个数量级的算力突破,成为下一代计算处理器。

然而,目前光计算芯片的性能(能耗、计算密度和算力大小等各个方面)仍然比电子计算芯片低很多,且可规模化程度低。主要原因包括:

(1)电光转换的效率较低导致的高能耗;

(2)集成光器件的尺寸较大导致单位芯片面积计算密度低;

(3)缺少非线性运算导致高延时。

(4)集成芯片元件数量的限制导致可规模化程度低等。

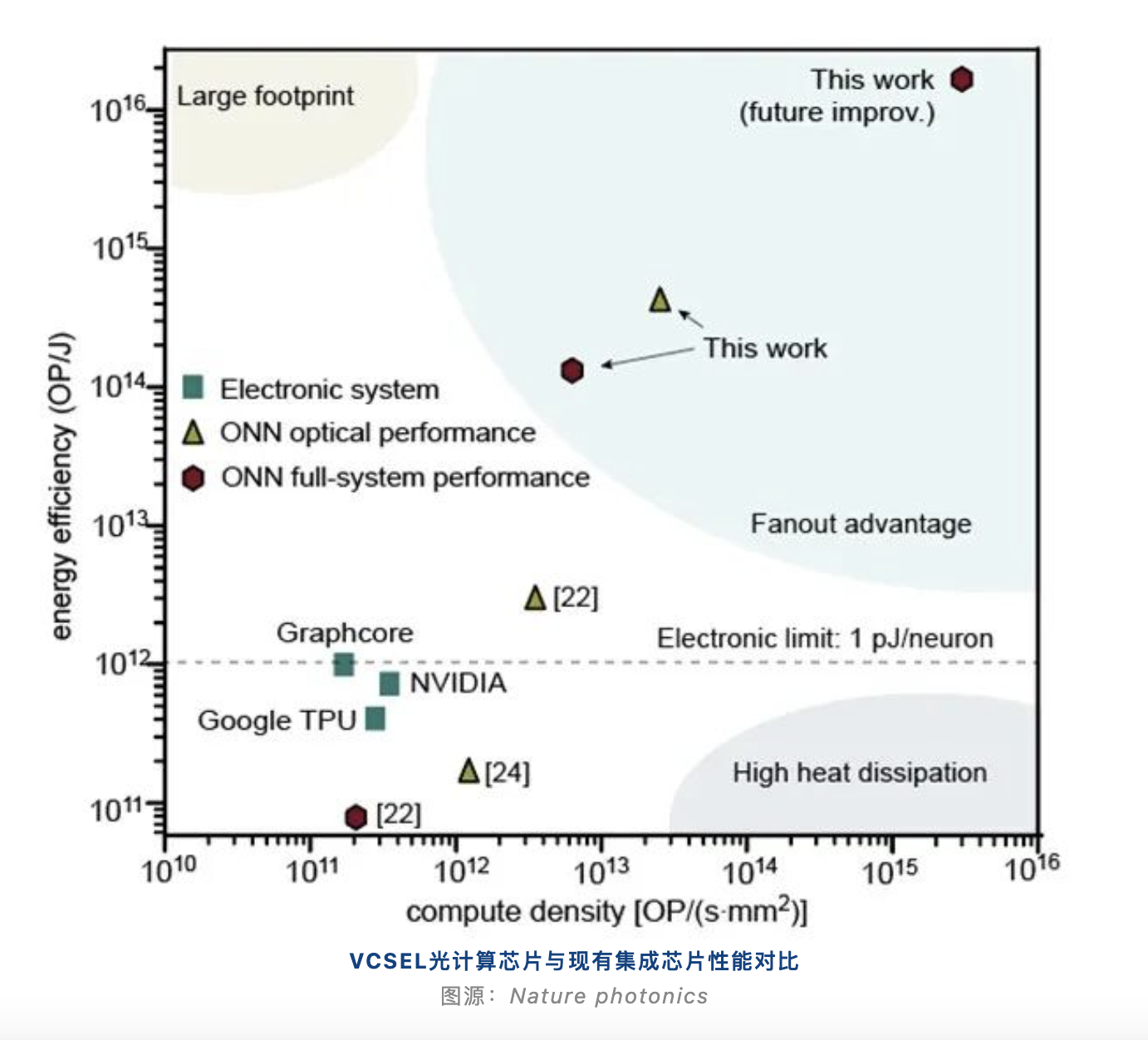

近日,麻省理工光学AI团队实现了从器件到芯片架构的全新设计。用激光阵列模拟细胞神经网络,开发了一种全新的光芯片架构,实现了整体性能突破。第一次实现光学计算芯片对电子计算的优势,提升了100倍的能量效率和20倍的计算密度,并有望在近期内实现多个数量级的提升。

该成果发表在Nature Photonics,题为“Deep Learning with Coherent VCSEL Neural Networks”。麻省理工学院的陈在俊博士(现为南加州大学电子工程系助理教授)为论文的第一作者兼通讯作者,Dr Ryan Hamerly(NTT)和Dirk Englund教授为共同通讯作者。

值得一提的是,这个工作在今年Photonics West上被评为“2023 年度SPIE 人工智能和机器学习最佳论文(唯一获奖者)”。

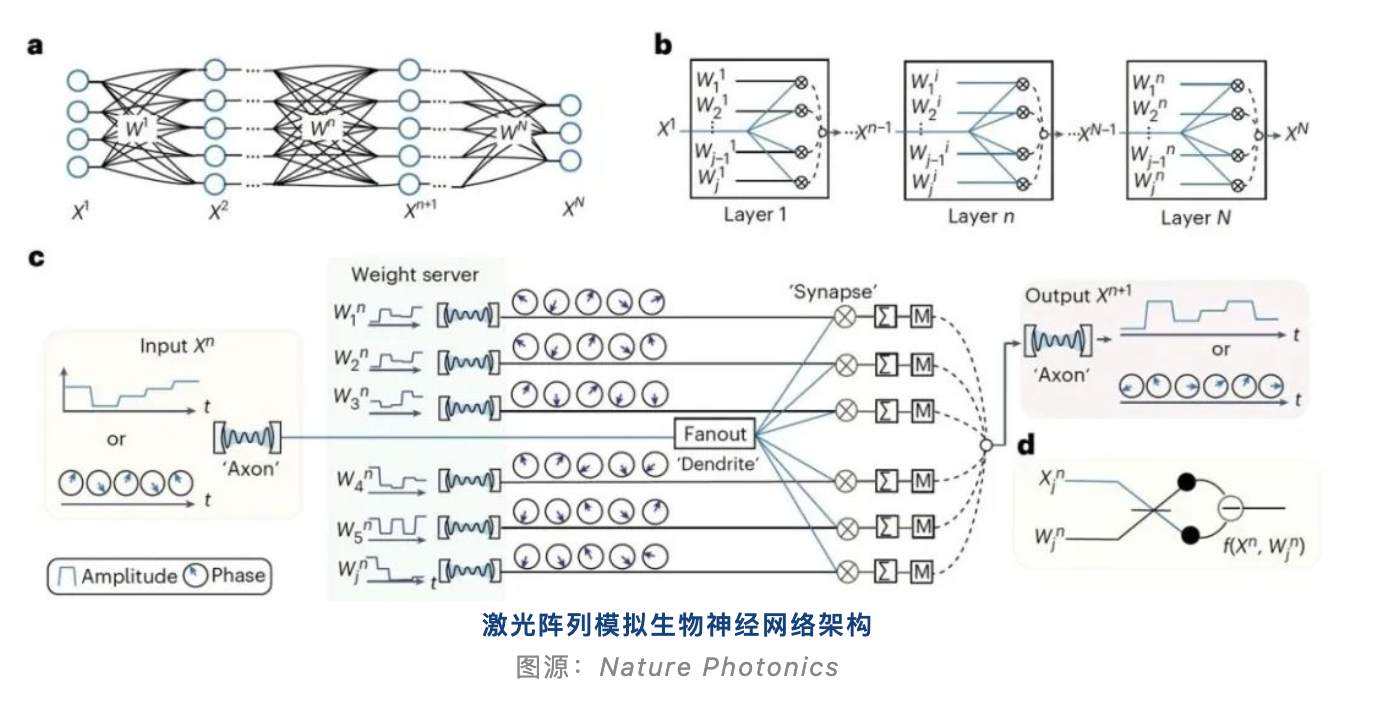

首次提出时间-空间复用光计算架构

该团队采用激光阵列模拟细胞神经网络(图1)。其中一个激光调制器作为神经元“Axon”激发输入信号Xi, 其他j个激光器激光作为权重服务器导入矩阵Wij。通过光场在探测器上干涉产生矩阵乘法Yj=XiWij。该计算架构最大程度地减少了系统的复杂性,减少了对光器件数量的要求。

超高效率的电光转换

该团队首次在光计算芯片中采用了大规模的VCSEL阵列做电光转换。这种调制器的在注入锁定模式下半波电压只有4 mV,每次转换消耗的能量仅有5 aJ(10-18焦耳),比目前最先进的电光调制器效率高了4-5个数量级。

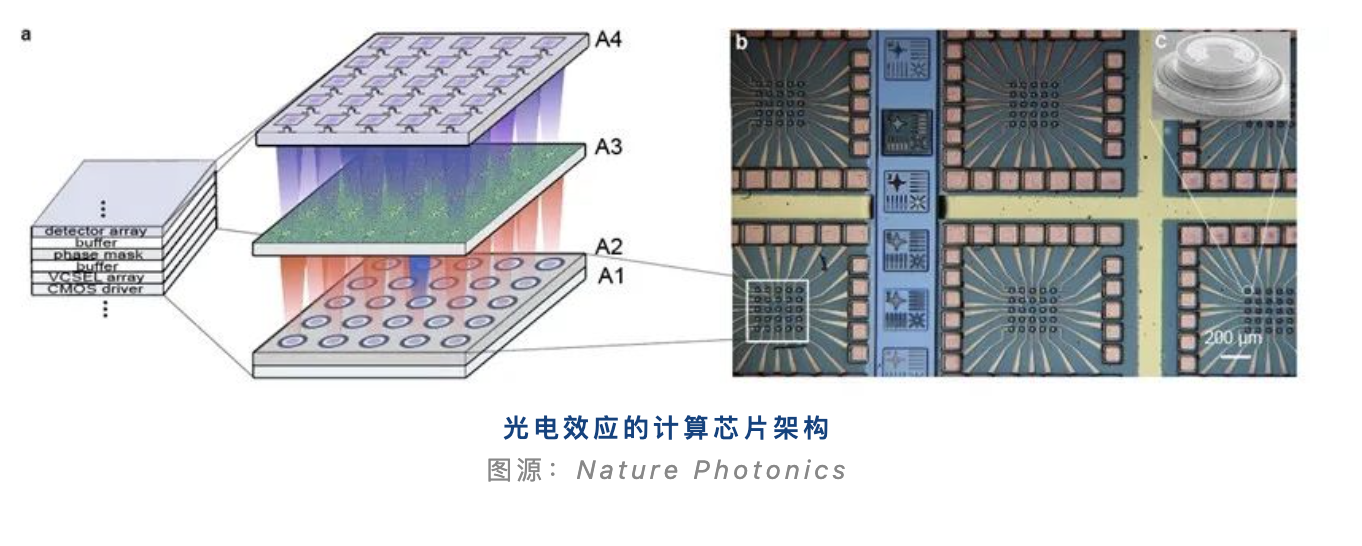

首次使用光电效应进行非线性运算

由于光子之间相互作用很低,光子非线性运算需要消耗较大的能量并且难于集成。该团队首次采用光电效应引入非线性:通过两束激光在探测器上进行干涉,可以通过改变其中一束激光的相位(或场强)去影响另外一束激光产生的光电流,从而实现非线性。这种非线性效应是瞬时响应,几乎没有延时。并且只需要在光探测器上实现,其尺寸可以在单波长级别,大大提高了芯片的集成效率。

总结与展望

MIT本次论文提出了很多全新的概念,从原件到架构上都有原创性突破,且做出了验证性实验 。首次实现了能量效率对电子计算有100倍的提高,并且集成密度增加了20倍。但是,受限于科研实验室条件的限制,实验中驱动了100个片上光元件。下一步的问题在于如何用更大的激光阵列做算力规模化。值得注意的是,文中用到的VCSEL光器件已经实现量产,且大规模应用于数据通信,人脸识别(如iPhone faceID),自动驾驶和激光打印中。文中通过对芯片的时钟频率、集成化,规模化做出了详细的分析,可在未来实现多个数量级的算力突破。

论文信息

Chen, Z., Sludds, A., Davis, R. et al. Deep learning with coherent VCSEL neural networks. Nat. Photon.(2023).

https://doi.org/10.1038/s41566-023-01233-w