答应大家要给一个ISSCC 2024的总结,终于得闲写了。ISCCC 2024或多或少具有具有里程碑含义,史上最高投稿量(873篇,往年都在600-650之间)。由于房间和时间的限制,这也导致近年来最低录用率(26.8%,往年在31-34%之间),组委会为了容纳更多的文章,也缩短了每个报告的时长,尽量在每个session多塞一个报告。其中,大陆+港澳占了69篇,再创新高,站稳第一位置,将美国(50+篇)远远刷在后面。这一期,小编聊聊AI大模型热门的大环境下这届ISSCC AI芯片的学术论文。

众里寻Transformer千百度

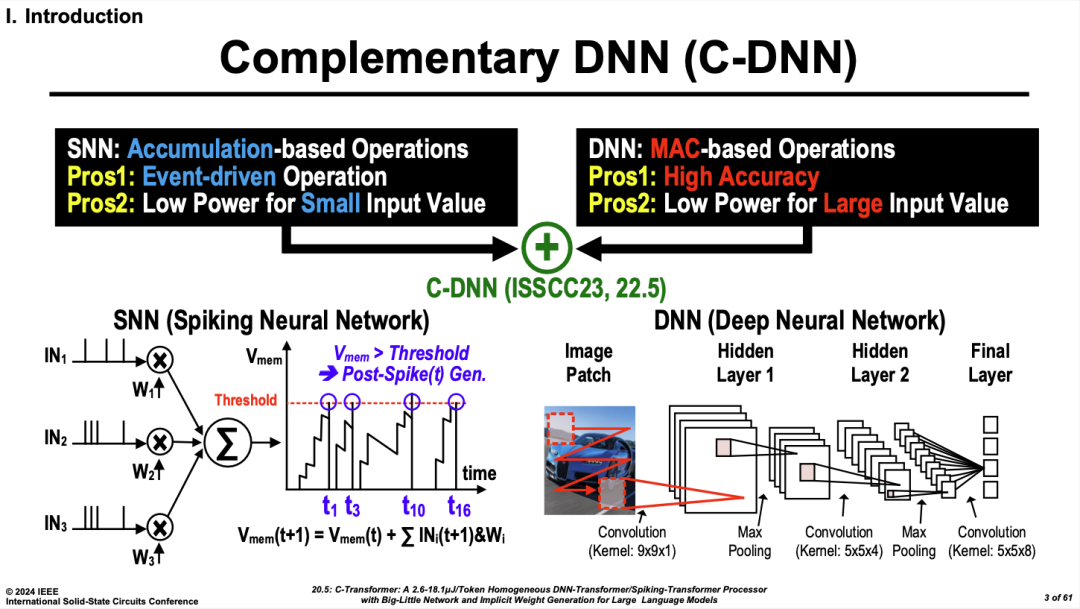

翻看今年的ISSCC Advanced Program,大家可以发现出现以大模型(LLM)、Transformer为题的文章少之又少。真正意义上,关于Transformer的数字芯片工作,仅有一篇,是来自韩国KAIST的C-transformer。这个工作的思想是将DNN transformer和Spiking (SNN)transformer融合,利用类脑SNN低位宽、高能效的特性,降低整个网络部署的能效。

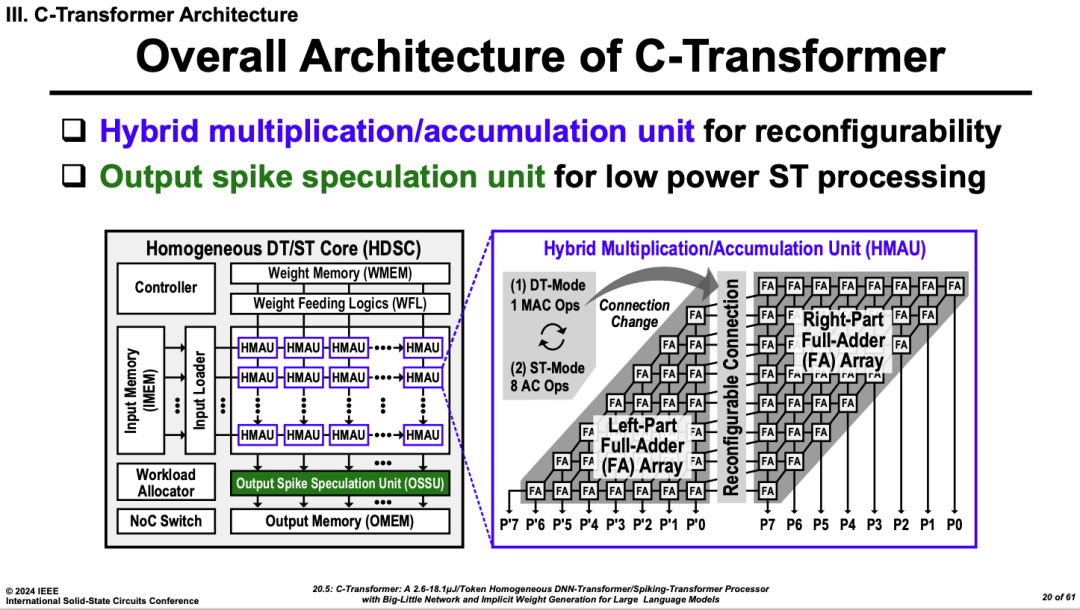

C-Transformer的核心想法是通过一个混合的乘累加的计算单元,它可以配置成两种模式,一种是标准的乘法式模式,用高精度的DNN计算,另一种是低位宽的Spiking模式,可以实现八个累加的计算。通过将计算单元配置成其中的某一种模式来映射DNN或者是SNN Transformer的计算.这一方法有点类似清华大学Tianji系列芯片。

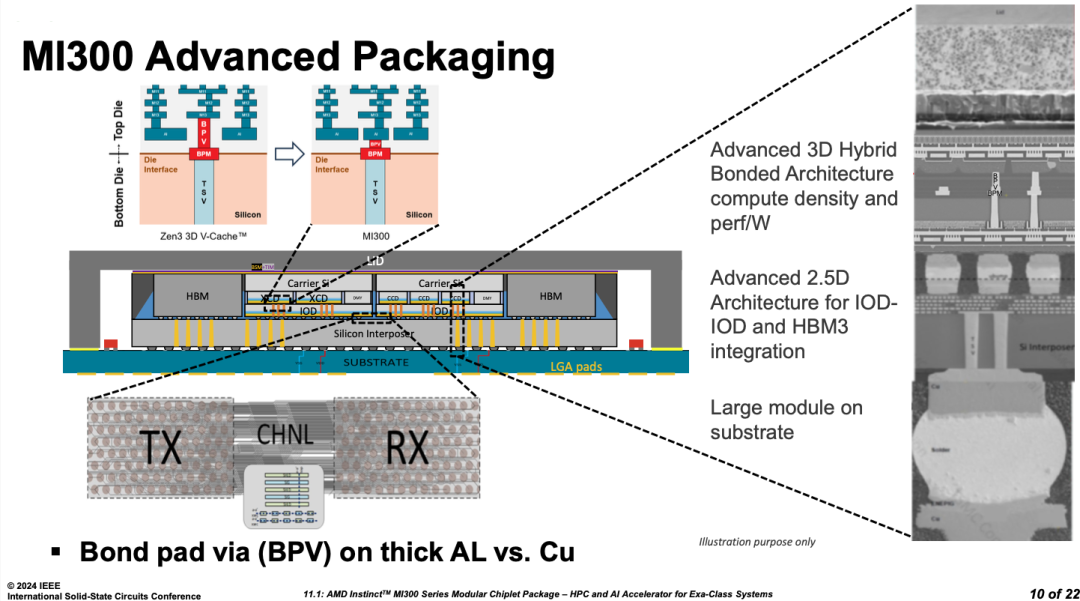

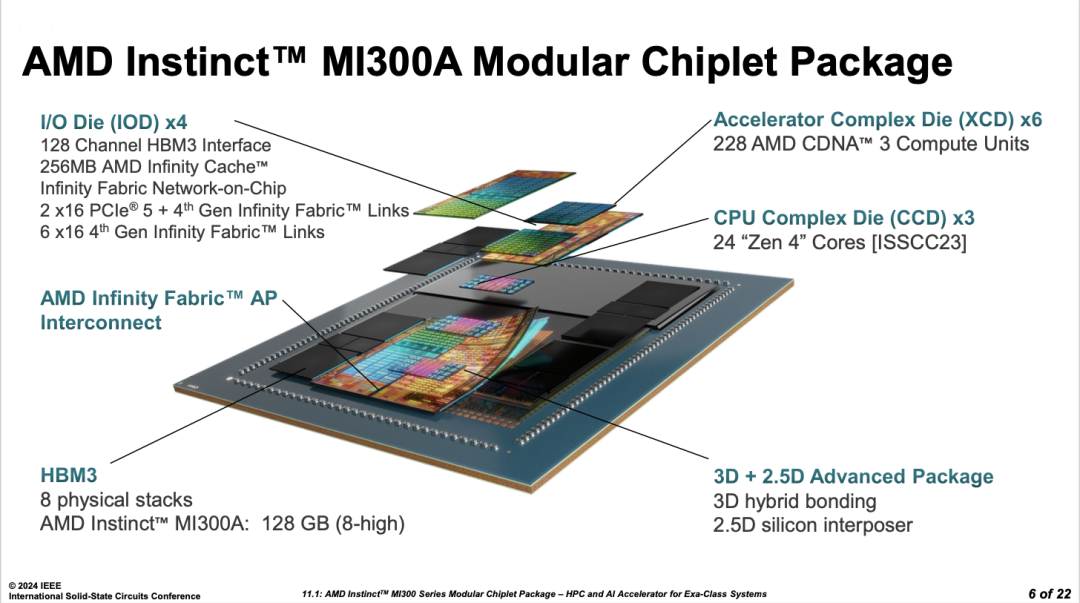

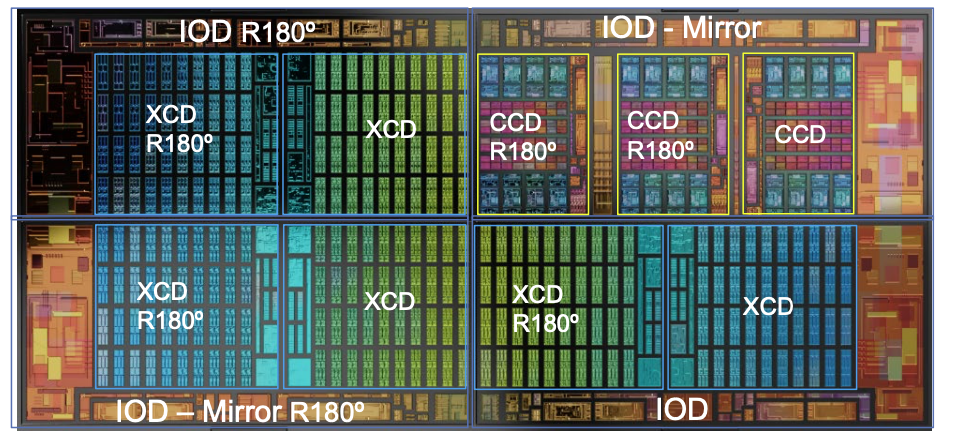

值得欣慰的是,Program还有两篇高性能的AI处理器,是提供Transfomrer的Benchmark结果,其中最具有最吸引眼球的无疑就是AMD的MI300系列。在工业邀请论文中,Instinct MI300系列作为一个AMD全新一代超算旗舰处理器,利用了各类三维集成芯片的技术,造出全新的庞然大物。即使只看结构,也可以感受到巧夺天工,它作为3层堆叠结构,包含了有源硅基板(Active Interposer, Base IO Die)、无源硅基板(Si Interposer)、hybrid bonding等各类技术。

从架构上,它既解决了单封装内仅仅增加GPU,而不提升CPU-PCIe控制端带宽导致的性能饱和,又首次实现了CPU Die在2两个完全不同的产品线上的复用,Zen 4CPU芯粒同时在MI300系列和EPYC Zen两个产品线复用。看着版图的俯视图,都觉得是一个艺术品。

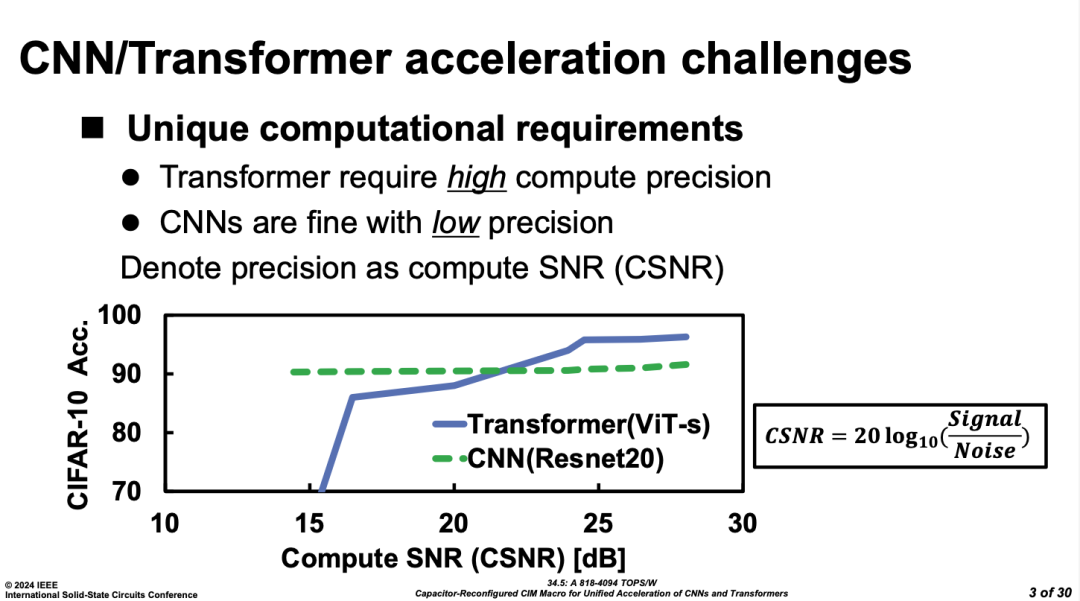

AI芯片在今年ISSCC较前两年ISSCC数量大幅减少的原因,主要是主要来自于Steering Committee将Machine Learning Track剔除,取而代之地增加了Security Track。ML芯片回归到传统digital architecture、digital circuit track和Memory track(存算部分)。当然,这也导致了今年论文的不少笑话,比如Compute-in-memory Session中有一篇号称支持Transformer的CIM,把Transformer CIM的要求定位为更高的精度(INT10b)。

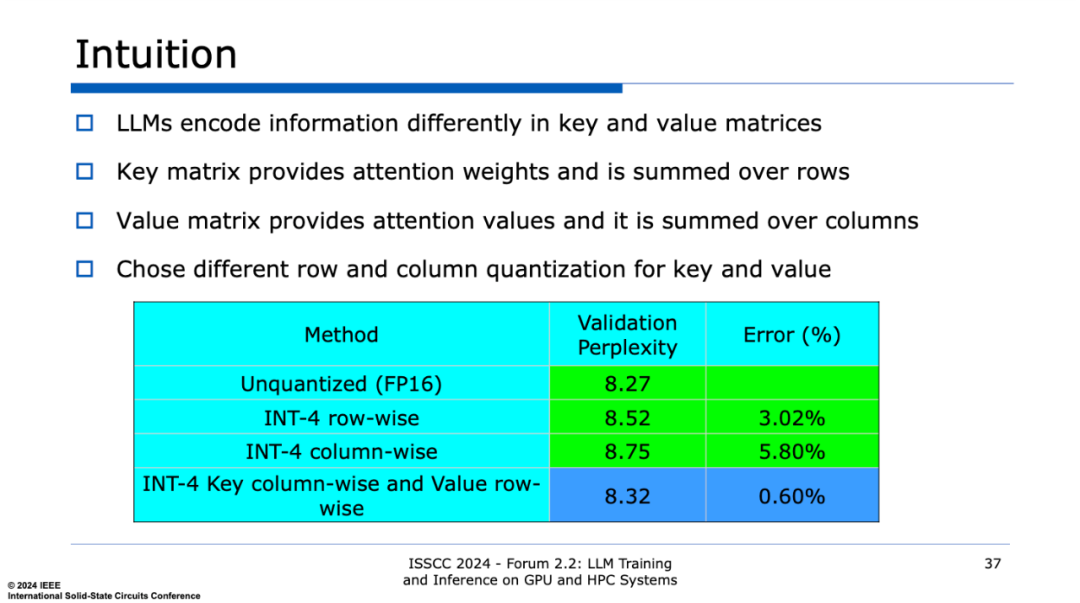

然而这个结论在Nvidia 的forum talk中啪啪打脸,现有大模型已经在INT4量化下的精度损失可以控制在0.6%以下。

小编觉得,或许这就是Memory designer 和Machine Learning SoC designer对于大模型算法发展的认识的时间差。也是取消ML track的一个坏处。

顺便提一句这个forum,今年的ISSCC单独设了一个面向大模型芯片的forum,这个论坛里邀请了来自英伟达、谷歌、Intel、三星等的多个大模型芯片公司的企业报告了最新的大模型进展,不得不说这个forum是整场ISSCC 会议中对于大模型芯片最大的亮点,小编尤为推荐英伟达在这个forum的talk。只可惜这个forum是要额外付钱。

数字芯片前沿聚焦机器人

另一个学术界无法实现大模型设计的主要原因是其规模,对学校和研究结构而言,不管是流片规模(经费)还是Co-design网络训练成本,都难以支撑B级以上模型的原型实验。所以,在今年的论文中,学校的大部分工作都转向了另外一个方向——智能机器人。这个领域有一个更高大上的名字:具身智能,我觉得可以理解为钢铁侠的贾维斯能干的事情。

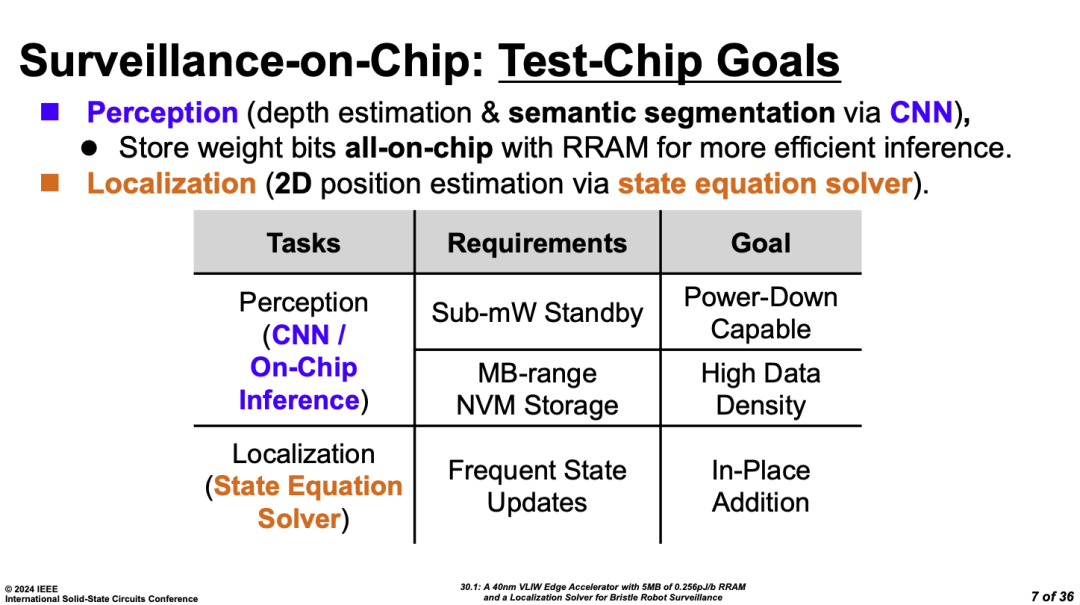

这个具身智能的芯片分为两类,一类是提升机器的本来能力,比如导航。美国佐治亚理工的团队提出了一个基于RRAM的导航机器人芯片,它具有两个功能,第一个功能是场景智能感知与理解,通过采用RRAM实现CNN等算法;第二个是对于环境中的导航定位,它主要来处理SLAM中状态方程的求解问题。

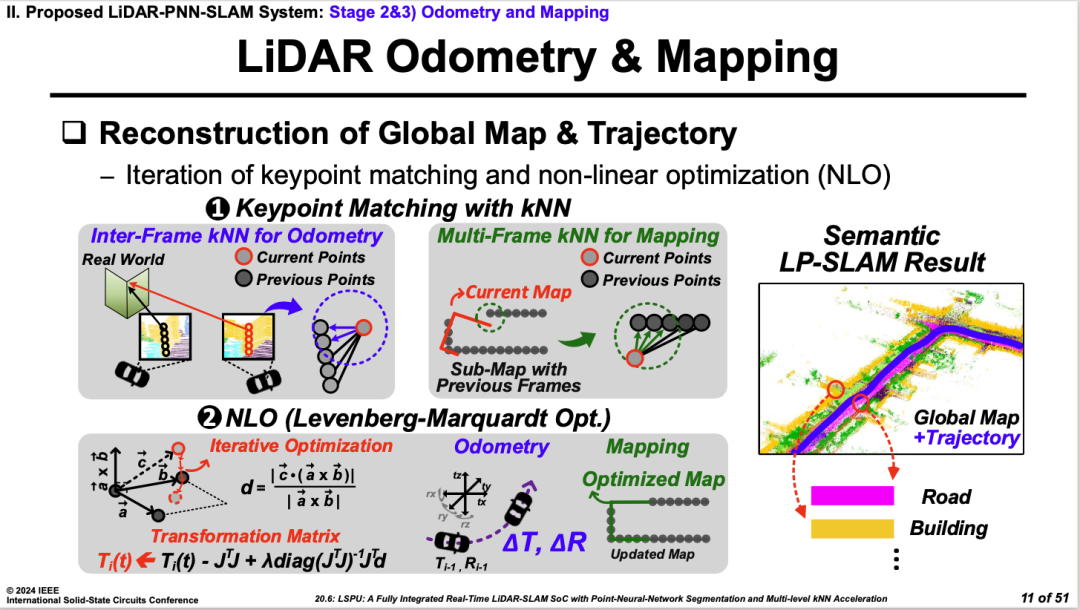

来自韩国蔚山科技学院(UNIST)的工作是一个面向激光雷达(Lidar)的3D点云的SLAM芯片,它既通过KNN完成了点云的本身信号处理。同时也通过加入非线性优化功能来完成SLAM的方程求解工作。

第二类是虚拟现实的图像场景生成,其中目前重要的算法是NERF(神经隐式建图),他的效果是通过对物体的简单学习,可以完成不同角度(光线投射下)物体的三维图像渲染和重现,有点类似元宇宙或者是Apple Vision Pro的建图。具体技术就不一一解释了(小编也不太懂),推荐如下两篇文章。

类似的虚拟现实工作还有来自清华大学的Diffusion SoC 芯片。更有甚者,把两者结合又成像又导航。可以想象为在虚拟现实中走了一个迷宫,最后拿到了文献中的上古宝物,有点类似盗墓笔记。(不过这篇文章除了把NERF、SLAM和MoE-多模态缝合起来,就做了一个MLP的加速,实际乏善可陈。)

存算一体的下一步是异构混合么?

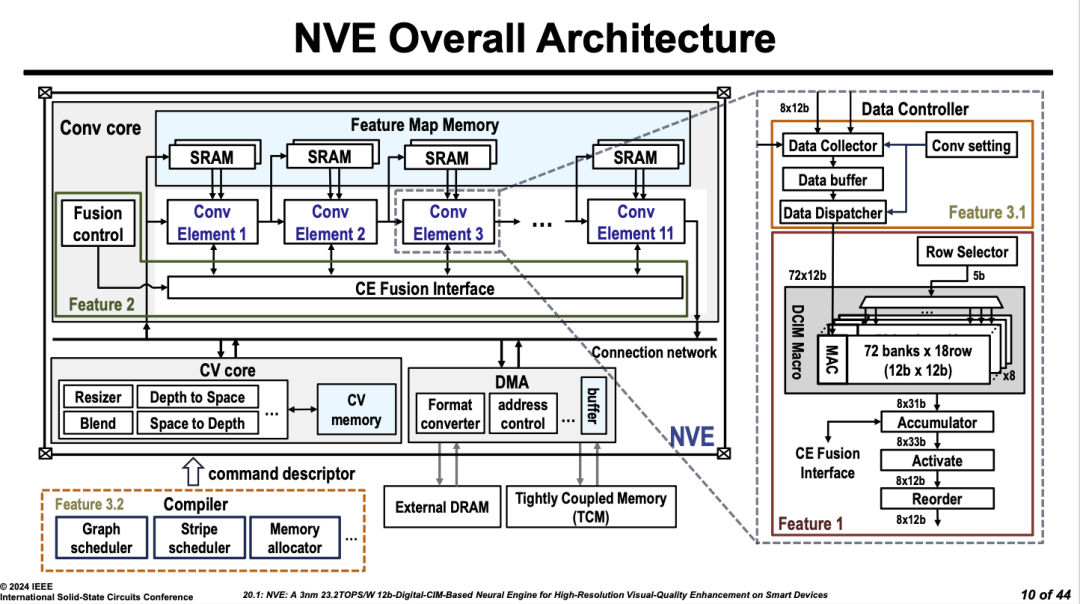

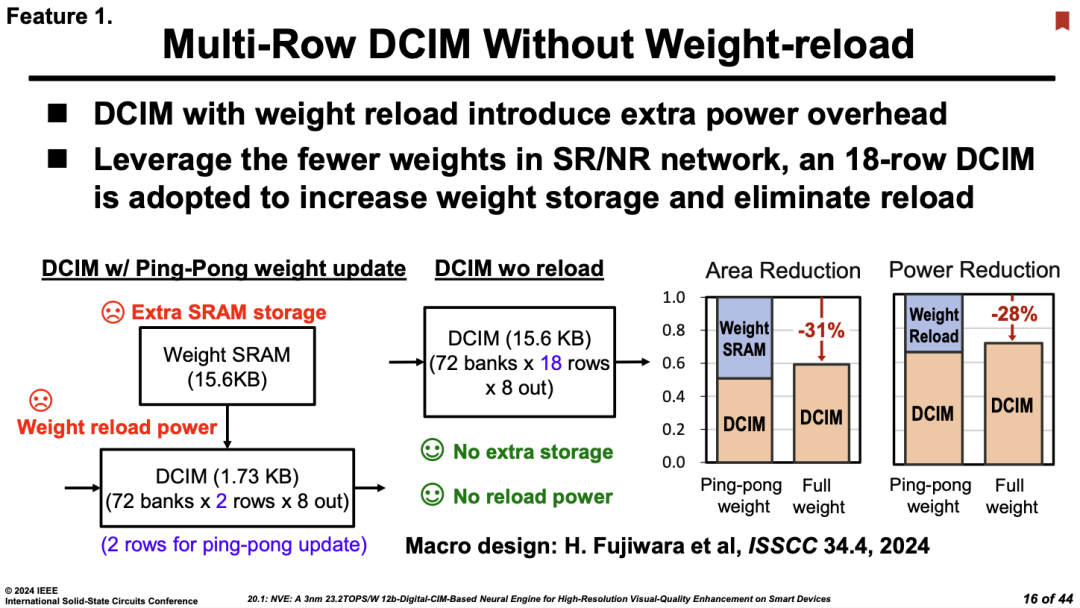

存算一体在历经了多年发展之后,今年ISSCC上最大存算亮点无疑是来自联发科与台积电。联发科发布了一个3nm NPU,其中的计算部分采用了TSMC 3nm最新一代存算核心,这个Macro实现也在今年CiM的Session中有一篇论文,真真的一次流片两篇论文。虽然这个存算一体的大部分技术沿用了TSMC DCIM经典路线(主要性能提升来源是3nm),但是联发科基于这个路线的技术开发了成熟的NPU产品,未来在手机上在产品中应用可期。

(顺带吐槽下,这个Multi-Row DCIM我们在ISSCC 2022上COMB-MCM提过)

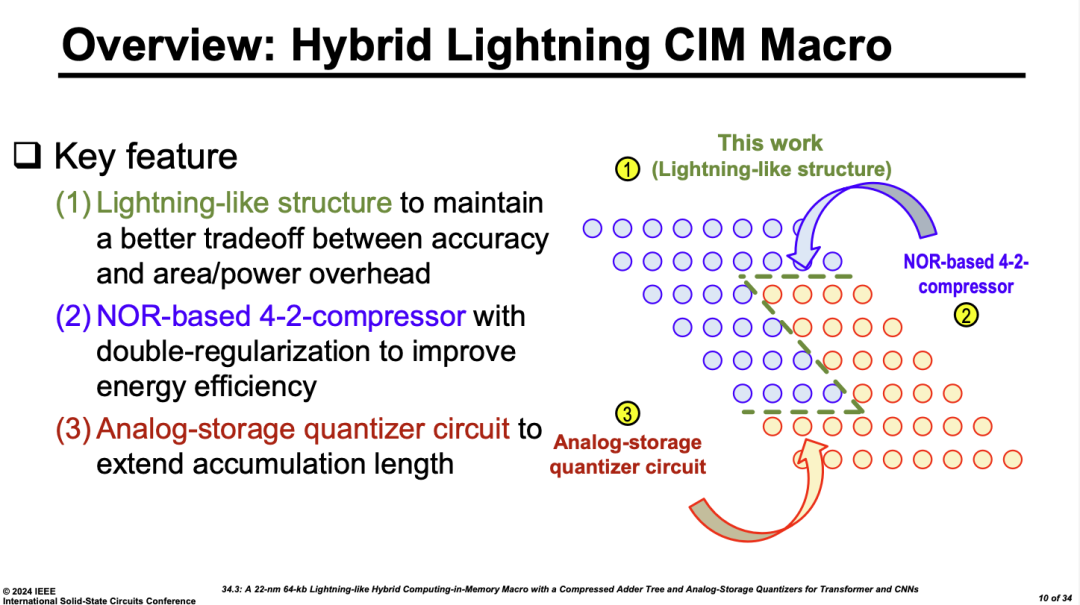

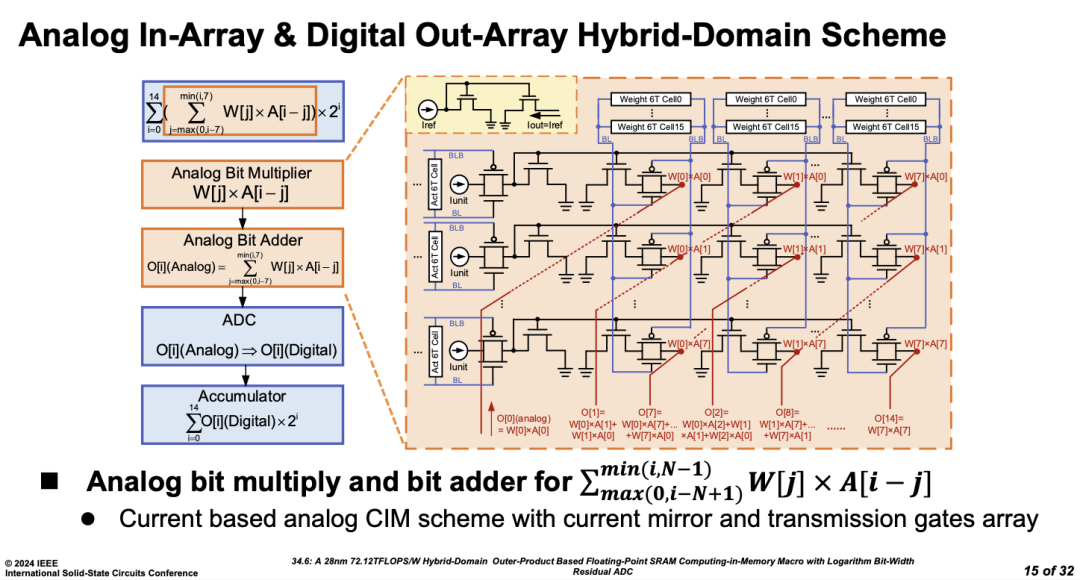

在没有更新工艺的加持下,在存算传统工艺赛道上(28/22nm节点)还有哪些花活呢?首先是卷浮点计算,毕竟INT CIM的计算能效已经上天了。另外,今年我们看到学术界的录用论文的不少创新都来自于四个字:混合异构。

第一种异构是不同电路计算机制的融合。东南大学和中科院微电子的两篇文章,都是通过模拟和数字的混合异构来保证精度的同时提升了计算能效,把对计算结果影响不那么重要的部分划给模拟做。如何选择模拟计算和数字计算的边界是有趣的讨论。

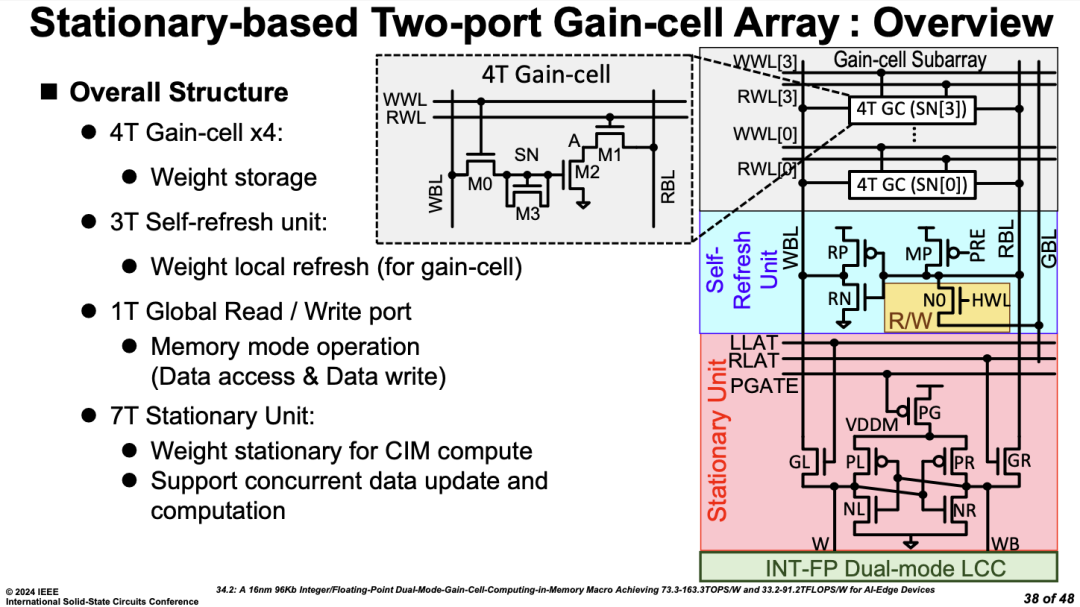

除了模拟和数字的异构外,还有不同存储介质的融合。台湾清华大学采用了4T Gain Cell(DRAM)和7T SRAM融合结构实现了面向数据流的存储优化架构。

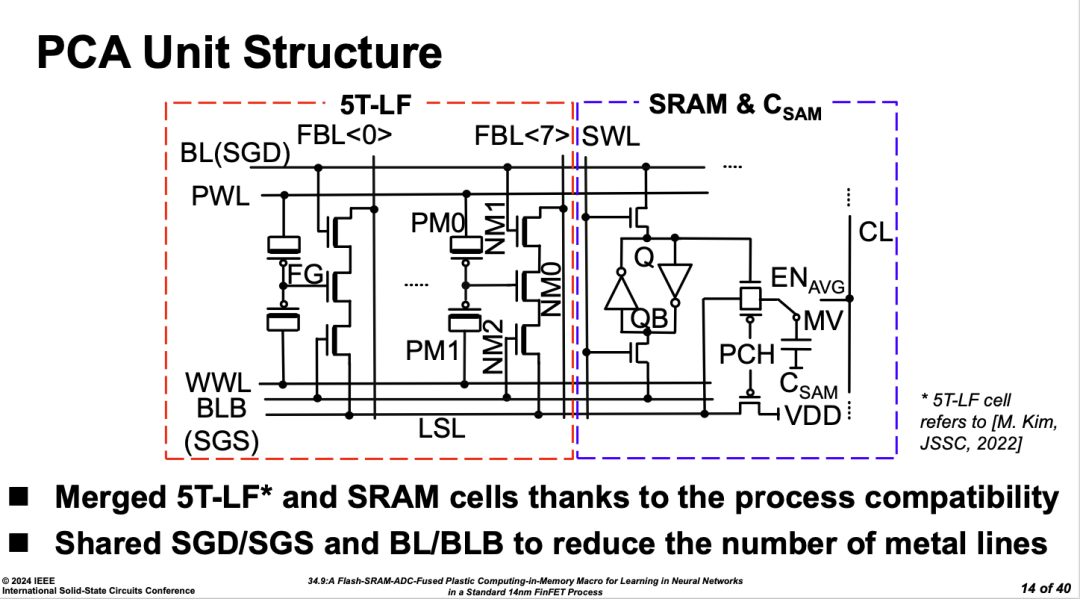

此外,微电子所还提出了Flash存算和SRAM存算融合的模式来模拟脑突触可学习的结构,实现片上的自学习能力。

其实Hybrid结构在许多ISSCC的track上都创新点的主要来源,比如Power和ADC两大模拟Track。在过去很长一段时间,原始架构的创新已经碰到了瓶颈,根据用途通过混合架构来提升性能(FoM)是非常有效的途径。这其中,如何选择异构的边界,如何折衷性能与loss是重要的科学问题。不过,在某种程度上,这是不是也意味着这个存算一体这个领域也已经从新兴学科逐渐进入了研究的瓶颈呢?

文章来源于矽说,作者痴笑

附下载:ISSCC 2024 Session,Digest,PPT(全)!