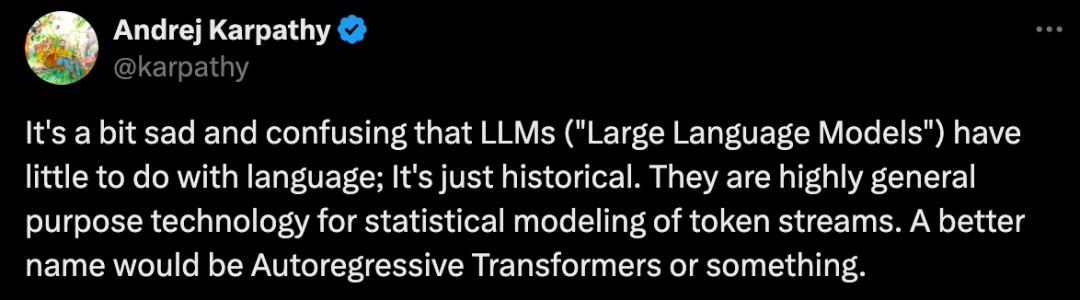

AI 大神 Andrej Karpathy 又开炮了!这次他吐槽的对象是“大语言模型”(LLM)这个名字:

“LLM(‘大语言模型’)和‘语言’没啥关系,这只是历史遗留问题。它们是一种高度通用的技术,用于对 token 流进行统计建模。一个更好的名字应该是‘自回归 Transformer’或其他类似的名字。”

Karpathy 认为,“语言”这个词误导了很多人,让人以为 LLM 只能处理文本,但实际上,LLM 可以处理任何类型的离散 token 流,例如图像块、音频块、动作选择、分子结构等等!

只要你能把问题转化成对 token 流的建模,你就可以“把 LLM 扔进去”! 😎

LLM 的未来:所有问题都将变成 token 流?

Karpathy 还大胆预测,随着 LLM 技术栈越来越成熟,很多问题最终都会被转化成 token 流建模问题。也就是说,问题的形式固定为“预测下一个 token ”,只是每个领域使用的 token 的含义不同。

如果真是这样,那么像 PyTorch 这样的深度学习框架就显得过于“臃肿”了。毕竟,如果 80% 的问题只需要用 LLM 就能解决,那谁还需要成千上万个可以任意配置的运算符和层呢?

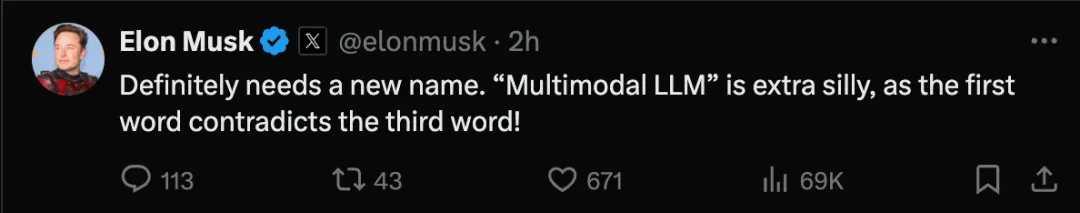

马斯克也来凑热闹:

“确实需要一个新名字。‘多模态 LLM(Multimodal LLM)’ 更是荒谬,第一个词和第三个词相互矛盾!”

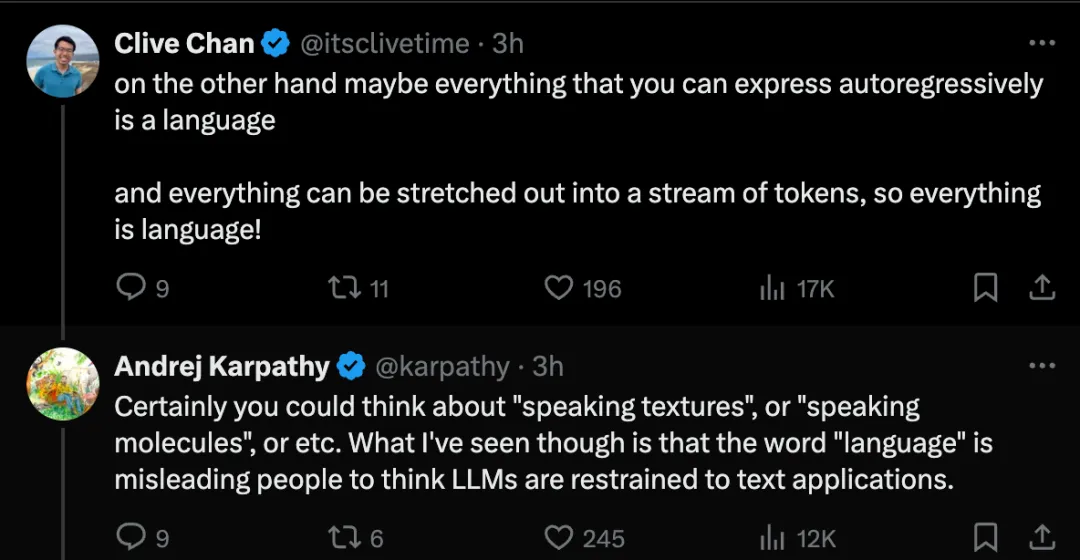

网友 Clive Chan 的观点更犀利:

“另一方面,也许所有可以自回归表达的东西都是语言,所有东西都可以扩展成一个 token 流,所以所有东西都是语言!”

Karpathy 最终总结道:

“当然,你可以把它想成‘说话的纹理’、‘说话的分子’等等。但我所看到的是,‘语言’这个词误导了人们,让他们认为 LLM 仅限于文本应用。”

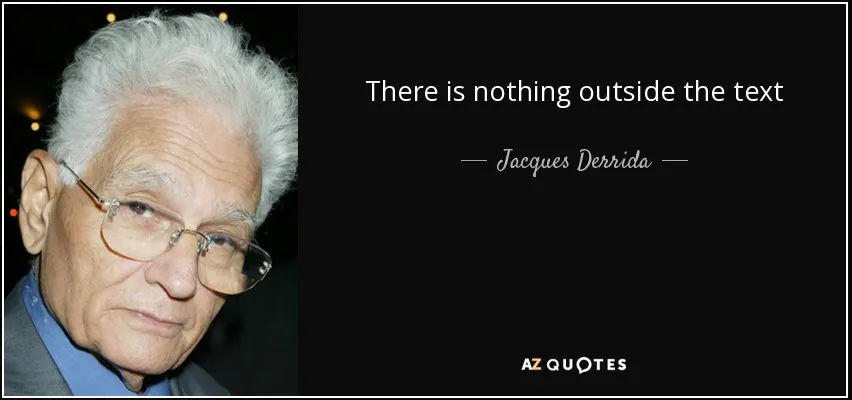

Karpathy讨论的其实非常有意思,我们来上点哲学高度,法国解构主义大师(解构主义鼻祖)Jacques Derrida有一个非常有名的观点"There is nothing outside the text"

这是不是人工智能与人文的交叉路口?乔布斯如果还在世的话,不知道他会如何解读?大家怎么看?评论区见