当前全球AI大模型和芯片领域掀起新一轮军备竞赛。

美国白宫周一发布声明称,总统特朗普签署了一项行政命令,启动一项旨在利用AI变革科学研究方式、加速科学发现的全新国家计划“创世纪计划”。

声明表示,该命令指示能源部创建一个人工智能实验平台,整合美国超级计算机和独特数据资产,以生成科学基础模型并为机器人实验室提供支持。

在AI大模型和芯片竞争背景下,对算力存在巨大需求。

谷歌在近期的海外巨头竞赛中阶段性胜出,AI基础设施负责人AminVahdat日前在全体大会中表示,公司必须每6个月将AI算力翻倍,并在未来4到5年内额外实现1000倍的增长,以应对持续上升的AI服务需求。

谷歌刚发布的大模型Gemini3和视频模型NanoBananaPro持续火爆,这些模型都是基于谷歌自研的TPU完成训练。

凭借TPU+大模型+应用+数据的全生态优势,谷歌有望最先实现AI生态闭环,引领AI产业进入“投入-成长-再投入”正循环,并有望引发全球大模型厂商的鲶鱼效应。

在之前的文章中,我们梳理了OCS光交换机全解析、光模块产业链全景解析、硅光模块梳理、国产AI算力数据中心全解析

本文重点解析TPU产业链以及核心环节。

01

TPU行业概览

TPU(Tensor Processing Unit,张量处理单元)是谷歌专为加速人工智能和机器学习任务设计的专用集成电路ASIC。

ASIC芯片:性能上针对特定任务的硬件架构优化使其计算效率远超通用芯片,流水线结构还能降低数据处理延迟;能效比卓越,功耗可比通用芯片低,以及散热压力更小。

TPU:从硬件到软件栈深度整合,支持谷歌AI生态的快速迭代。其核心优势在于“用硬件定义算法”,高效矩阵运算、能效比突出以及定制化设计。与通用计算芯片不同,TPU的硬件设计完全围绕深度学习中最核心的张量运算展开,针对深度学习中的矩阵乘法、卷积等张量操作优化。

TPU的硬件架构组成

TPU的硬件架构围绕"计算-存储-互联"三大核心模块展开。

核心计算单元采用脉动阵列结构,由数千个算术逻辑单元(ALU)组成二维网格,数据通过流水线方式在阵列中传递,每个周期可完成数千次乘加运算(MAC)。

通过硬件架构的专用化实现计算效率的数量级提升,TPU的算力密度远超通用CPU/GPU。

TPU发展历程

谷歌TPU自2015年首次推出以来,历经多次迭代升级,TPU逐步形成完整的技术体系。

Trillium:2024年发布的第6代Trillium新增MLP核心,专为Transformer大模型优化,进一步提升了大模型的训练速度与效率。

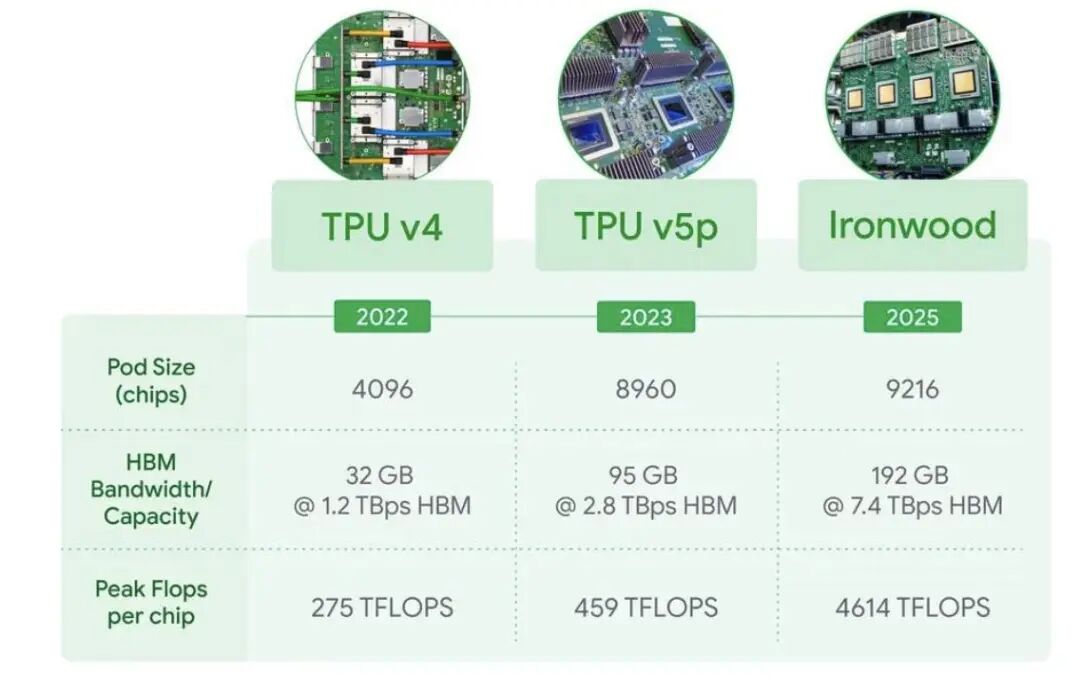

Ironwood:谷歌正式发布的第七代TPU"Ironwood",是目前谷歌性能最强大、能效最高的定制芯片。Ironwood实现算力、能效与生态的三重突破。单芯片算力4614TFLOPs(FP8精度),集群规模扩展至9216颗芯片。算力达42.5ExaFLOPs,相当于全球最强超算ElCapitan的24倍,训练和推理性能比第六代TPU(Trillium)提升4倍。

TPUIronwood的推出标志着AI算力从“单芯片竞争”转向“系统级竞争”,其算力爆发与OCS技术创新为产业链带来重构机遇。

02

谷歌TPU产业链核心环节

芯片设计

整个产业链的核心和技术壁垒。

谷歌自主掌控TPU的架构设计,从TPU v1到最新v7(Ironwood)的全代际架构设计,包括稀疏计算单元(SparseCore)、3D Torus互联拓扑、HBM内存集成等核心技术的研发。

TPU设计架构图:

数据来源:Norman P. Jouppi《In-Datacenter Performance Analysis of a Tensor Processing Unit》

数据来源:Norman P. Jouppi《In-Datacenter Performance Analysis of a Tensor Processing Unit》

OCS光交换

大模型训练需要海量GPU/TPU协同计算,对通信带宽和时延提出极高要求,OCS网络在能耗/延时/宕机时间/升级迭代等多个方面具备显著优势。

谷歌是目前OCS最大的采购方,在OCS布局多年,在2022年首次将OCS引入TPUv4网络中且在后续一直沿用。

谷歌数据中心采用48台OCS光交换机互联9216颗TPU,网络宕机时间从2000小时延长至10万小时。

根据SemiAnalysis,谷歌的OCS定制化网络使其整个网络的吞吐量提升了30%,功耗降低了40%,数据流完成时间缩短了10%,网络宕机时间减少了50倍,且资本开支减少了30%。

此外,OCS可将交换机和光纤升级到更快的几代,而无需更换网络的“主干”,使用寿命比传统EPS长得多。

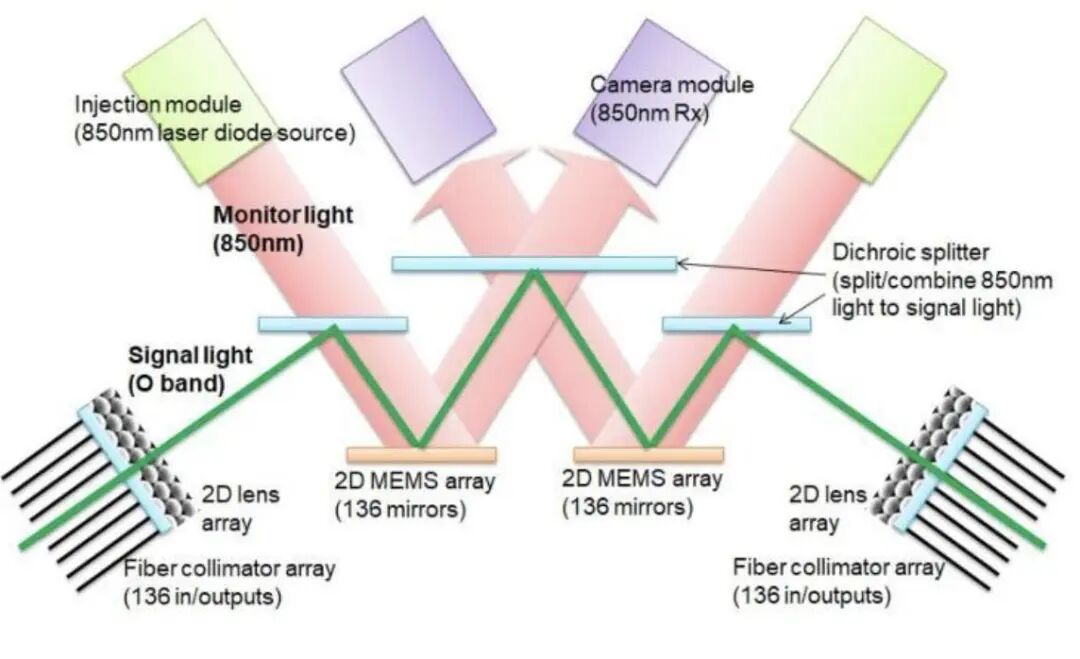

OCS光交换机核心技术:目前主要有四种方案:MEMS方案、数字液晶技术(DLC)、压电Directlight光束偏转技术(DLBS)和光波导方案。

MEMS目前相对成熟,是OCS市场中占比超过70%的主流方案,其端口扩展能力和成本控制比较均衡。全球主要厂商中,谷歌和Lumentum以MEMS方案为主,谷歌核心采用的MEMS微镜方案光路切换延迟仅10-100纳秒。

MEMS示意图:

谷歌OCS供应格局:目前谷歌的直接供应商主要为海外厂商Lumentum与Coherent等厂商,国内厂商目前已经参与到元器件与代工产业链中。谷歌国内OCS产业链相关配套厂商包括德科立(整机)、赛微电子(MEMS芯片代工、OCS关键的微镜阵列晶圆)、光库科技(收购武汉捷普光学业务,切入MEMSOCS整机代工,间接供应谷歌)、腾景科技(供应OCS核心光学元件)等。

除谷歌外,OCS有望在其他CSP中得到更多重视和应用,当前微软、Meta、亚马逊AWS也都在探索自己的光交换网络。

TPUV5e(256TPU)实物图:

资料来源:谷歌

资料来源:谷歌

光模块&铜缆

TPU集群通过光模块实现芯片间ICI的高速数据传输,支撑大规模分布式计算。

谷歌第七代TPU(Ironwood)单集群串联超9000颗芯片,需部署超10万只光模块,构建低延迟、高带宽的3D环面拓扑网络,当前高速率的1.6T光模块成为刚需。

高速光模块:作为OCS系统的核心组件,需与MEMS光开关、液晶阵列等器件协同,提升网络灵活性和可靠性。因单芯片ICI带宽提升至1.2TBps(9.6Tbps双向),需更高速率光模块支撑。中际旭创(谷歌1.6T光模块独家供应商,产品适配2026年TPU扩张需求)、新易盛(为谷歌TPU边缘节点提供800G光模块)、太辰光MPO光纤连接器作为光通信配套供应谷歌,适配数据中心高密度互联需求。

1.6T光模块成为刚需,因单芯片ICI带宽提升至1.2TBps(9.6Tbps双向),需更高速率光模块支撑。

带有环形器的定制光模块:

资料来源:Google,aster

资料来源:Google,aster

铜缆:随着TPU芯片数量指数级增长(如从v4的4096颗增至Ironwood的9216颗),铜缆的带宽和距离限制愈发明显。国内铜缆相关厂商中,长芯博创与Marvell合作的1.6TAEC有源铜缆已向谷歌送样,适配TPUv7集群需求。通宇、长飞、汇绿、瑞可达、意华、胜蓝、兆龙等众多厂商在铜缆环节有所布局。

液冷散热

随着TPU芯片数量指数级增长,如从v4的4096颗增至Ironwood的9216颗,传统风冷技术已无法满足散热需求。

液冷通过直接接触芯片散热,将单机柜功率密度提升至80kW以上,支持超大规模集群稳定运行。

谷歌新一代TPU芯片Ironwood的液冷系统使9216颗芯片集群温度波动控制在±2℃以内,确保算力密度与算法优化的双重优势。

液冷技术显著减少冷却系统能耗。以Ironwood集群为例,液冷技术使其能耗效率提升50%,相当于花同样电费获得双倍算力。

国内相关厂商中,英维克CDU支持超2.6万台液冷节点部署,适配谷歌AI芯片高功耗需求,产品进入谷歌服务器供应链,提供全产业链液冷方案(从冷却液到CDU、电磁阀等组件)、思泉新材超薄VC均热板通过谷歌认证,新雷能切入谷歌TPU电源供应链,提供二次和三次电源模块、工业富联全球首创“冷板式+浸没式”混合液冷方案,获谷歌能效认证,适配TPU-v6集群部署。

PCB

TPU作为谷歌AI算力的核心硬件,其性能提升依赖PCB印制电路板的技术迭代。

PCB作为芯片模组与整机的物理载体,直接决定算力设备的传输效率。

TPUV7/V8世代对PCB的“高带宽、低延迟、高可靠性”要求远超传统服务器,需支持224Gbps以上传输速率。

单块PCB板需集成8个TPU芯片或4块GPU/TPU模块,通过光模块实现高速互联,对PCB层数、布线密度提出严苛要求。

TPUV7主版本为36层板,V7P版本升级至44层板,单价从1.5万元提升至2.5万元人民币。40层以上PCB需优化导热设计,国内厂商已布局液冷方案,适配TPU高功耗散热需求。

2026年谷歌计划将覆铜板(CCL)从马8等级升级至马9(高频高速特性更优),推动PCB价值量进一步提升。V8世代可能引入HDI(高密度互连)技术,以提升传输速率至300Gbps,进一步优化PCB性能。沪电股份主导30-40层板生产、胜宏、中富电路等谷歌TPU的核心PCB供应商、深南电路作为谷歌TPUV7芯片高端PCB独家供应商,供应44层板。

据悉,MetaPlatforms正考虑斥资数十亿美元购买谷歌的TPU,包括用于Meta的数据中心建设。而人工智能初创公司Anthropic计划使用多达100万个新TPU来运行其Claude模型。谷歌凭借“AI应用(搜索、广告、视频)-大模型(Gemini)-算力(TPU)-网络设备(OCS)”打造的全栈布局模式,未来在AI时代具备广阔发展前景,谷歌有望引领新一轮AI算力机遇。