5月18日,一颗炸弹在AI绘图圈炸响。

从此,AI可以精准修图了,哪里不准修哪里,AIGC,已然到达了全新的里程碑!

这篇引爆绘图圈的核弹级论文,名为「Drag Your GAN」,由MPII、MIT、宾大、谷歌等机构的学者联合发布。目前已被SIGGRAPH 2023录用。

而且因为太过火爆,这个项目一经发布,网页就经常处于崩溃状态。

项目地址:https://vcai.mpi-inf.mpg.de/projects/DragGAN/

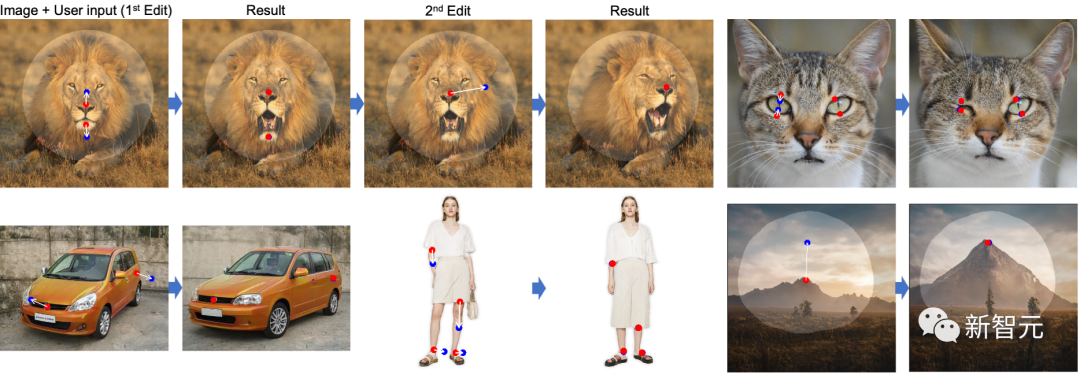

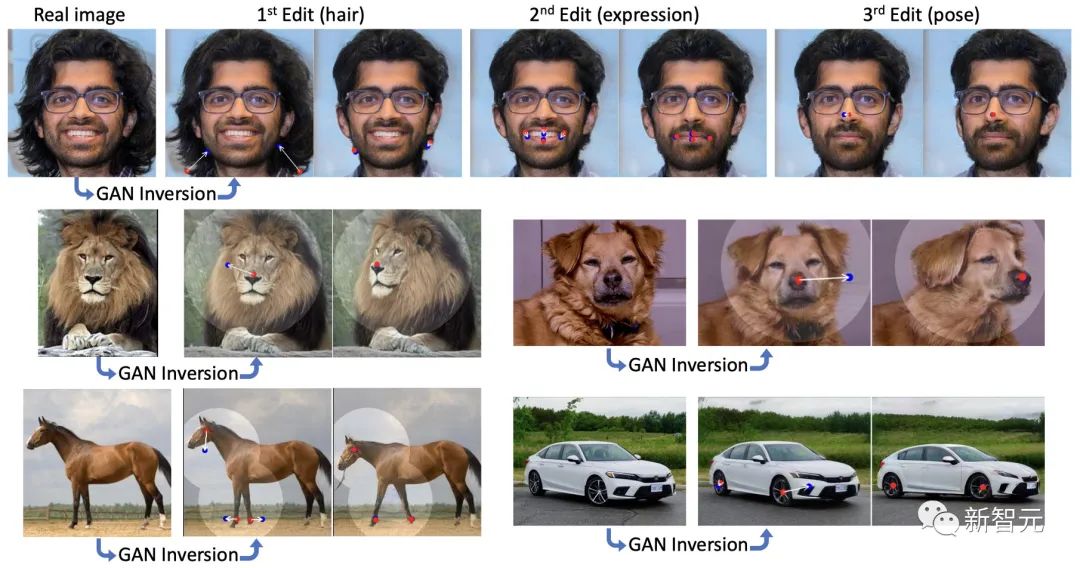

顾名思义,通过DragGAN,就可以任意拖动图像了,无论是对象的形状、布局、姿态、表情、位置、大小,都可以做到精准控制。

只要拖拽动作,确定生成图像的起点和终点,再根据对象的物理结构,用GAN生成在精细尺度上符合逻辑的图像,一张挑不出破绽的图就生成了。

拍的照片表情不好?修!脸型不够瘦?修!脸冲镜头的角度不对?修!

(简直就是一个超强版的Photoshop)

轻轻一拖动,就能想把耷拉着的狗耳朵提起来,让狗狗从站着变成趴下,以及让狗狗瞬间张嘴微笑。

现在,甲方提出「让大象转个身」的要求,终于可以实现了。

所以,广大修图师的饭碗是要被端了?

从此,我们正式进入「有图无真相」时代。

准备好,一大波演示来了

这种DragGAN可控图像合成方法,具有广泛的应用场景,只有你想不到,没有它做不到。

Midjourney、Stable Diffusion、Dalle-E等AI绘图工具生成的图像,都可以用DragGAN来微调细节,生成任何想要的效果。

模特的姿势可以随意改变,短裤可以变成九分裤,短袖可以变长袖。

湖边的树可以瞬间长高,湖里的倒影也跟着一起改变。

原图中的太阳没露脸?无所谓,DragGAN会给你造个日出。

猫猫的正脸一下子变侧脸,角度精细可调。

甚至连汽车也能一键「敞篷」。

不得不说,AI绘图圈,真的太卷了。上一个工具还没完全学会呢,下一个革命性产品就又来了。

有了DragGAN的加持,各种AI画图工具的「阿喀琉斯之踵」再也不是弱点。

并且,DragGAN在单颗3090显卡上生成图像,仅仅需要几秒钟。

可以想象,绘图、动画、电影、电视剧等领域,都将迎来大地震。

DragGAN看起来像Photoshop的Warp工具,但它的功能实现了核弹级的增强——它让你不只是在像素周围简单地移动,而是使用AI来重新生成底层对象,甚至还能像3D一样旋转图像。

研究者团队指出,这项工作真正有趣的地方不一定是图像处理本身,而是用户界面。

我们早就能用GAN之类的AI工具来生成逼真的图像,但缺乏足够的灵活性和精度,无法得到我们想要的确切姿势。

但DragGAN提供的,绝不是简单地涂抹和糊化现有像素,而是重新生成主体。

正如研究者所写:「你的方法可以产生幻觉,就像狮子嘴里的牙齿一样,并且可以随着物体的刚性而变形,就像马腿的弯曲一样。」

DragGAN的横空出世表明,GAN模型开始模型了,或许它会比Diffusion模型(DALLE.2、Stable Diffusion和Midjourney)更具影响力。

此前,Diffusion模型一直在AI绘图领域大受欢迎,但生成式对抗网络GAN也引起了人们广泛的兴趣,Ian Goodfellow2017年提出GAN理论后,三年后它再次复兴。

DragGAN:图像处理新时代

在这项工作中,团队研究了一种强大但还未被充分探索的控制GAN的方法——以交互的方式将图像中任意一点精确「拖动」至目标点。

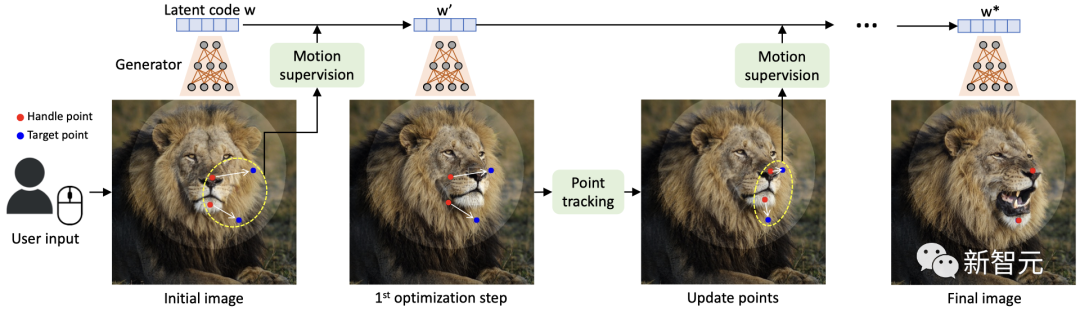

DragGAN主要包括以下两个主要组成部分:

1. 基于特征的运动监控,驱动操作点向目标位置移动

2. 一个新的点跟踪方法,利用区分性的GAN特征持续定位操作点的位置

通过DragGAN,任何人都可以对像素进行精确的控制,进而编辑如动物、汽车、人类、风景等多种类别的姿态、形状、表情和布局。

由于这些操作在GAN的学习生成图像流形上进行,因此它们倾向于生成逼真的输出,即使在富有挑战性的场景下也是如此,例如被遮挡的内容和变形的图像。

定性和定量的对比表明,DragGAN在图像操作和点跟踪任务中,都明显优于先前的方法。

拖拽编辑

在DragGAN的加持下,用户只需要设置几个操作点(红点),目标点(蓝点),以及可选的表示可移动区域的mask(亮区)。然后,模型就会自动完成后续的图像生成,

其中,动态监控步骤会让操作点(红点)向目标点(蓝点)移动,点追踪步骤则通过更新操作点来追踪图像中的对象。此过程会一直持续,直到操作点达到其相应的目标点。

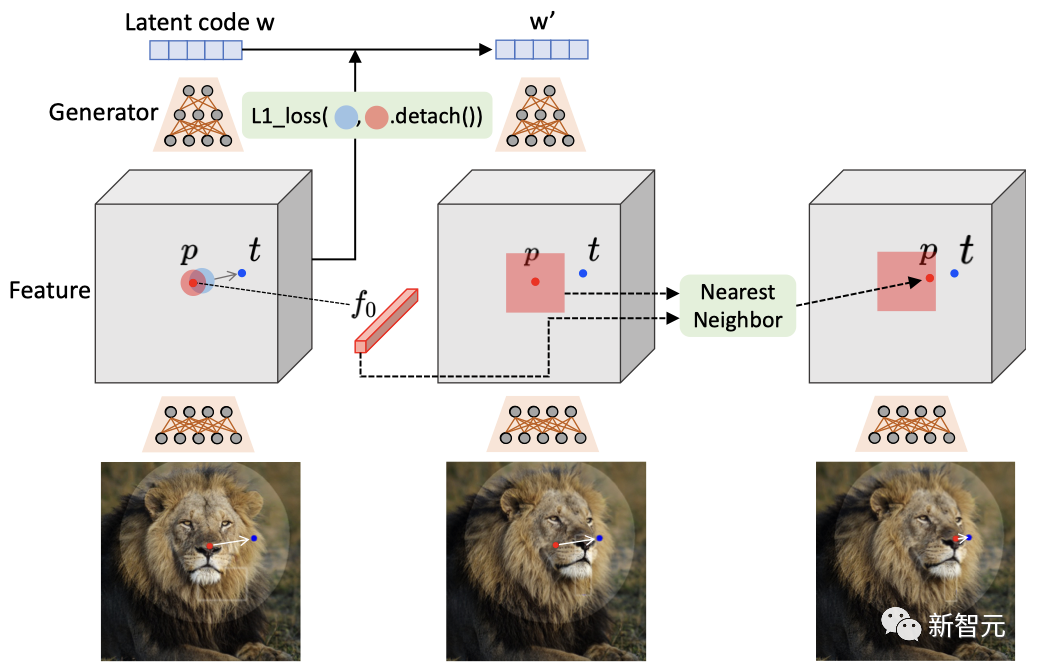

流程

具体来说,团队通过在生成器的特征图上的位移修补损失来实现动态监控,并在相同的特征空间中通过最近邻搜索进行点追踪。

方法

值得注意的是,用户可以通过添加mask的方式,来控制需要编辑的区域。

可以看到,当狗的头部被mask时,在编辑后的图像中,只有头部发生了移动,而其他区域则并未发生变化。但如果没有mask的话,整个狗的身体也会跟着移动。

这也显示出,基于点的操作通常有多种可能的解决方案,而GAN会倾向于在其从训练数据中学习的图像流形中找到最近的解决方案。

因此,mask功能可以帮助减少歧义并保持某些区域固定。

mask的效果

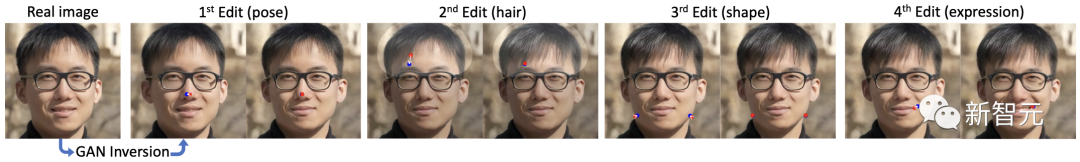

在真实图像的编辑中,团队应用GAN反转将其映射到StyleGAN的潜在空间,然后分别编辑姿势、头发、形状和表情。

真实图像的处理

到目前为止,团队展示的都是基于「分布内」的编辑,也就是使用训练数据集内的图像来实现编辑。

但DragGAN实际上具有强大的泛化能力,可以创建出超出训练图像分布的图像。比如,一个张得巨大的嘴,以及一个被极限放大的车轮。

在某些情况下,用户可能希望始终保持图像在训练分布中,并防止这种超出分布的情况发生。实现这一目标的方法可以是对潜在代码添加额外的正则化,但这并不是本文讨论的重点。

泛化能力

比较分析

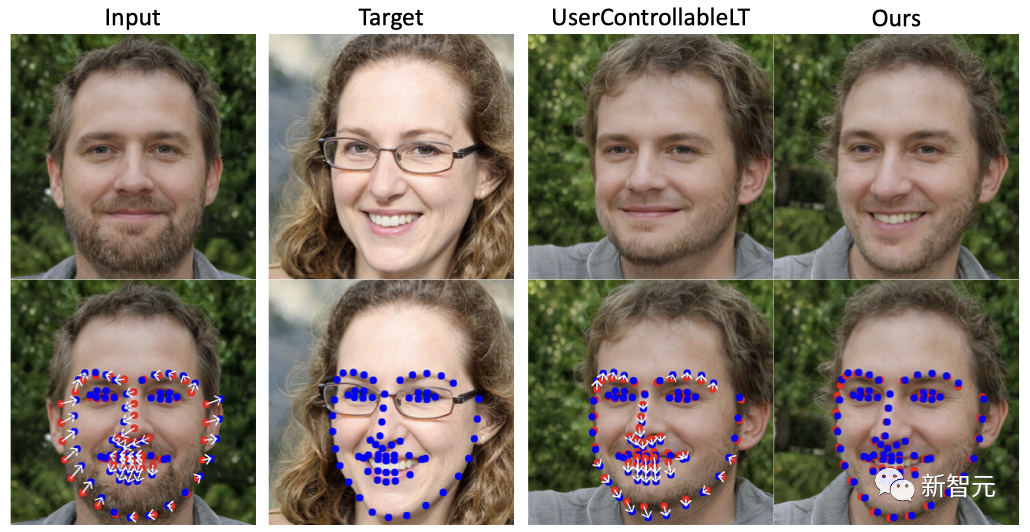

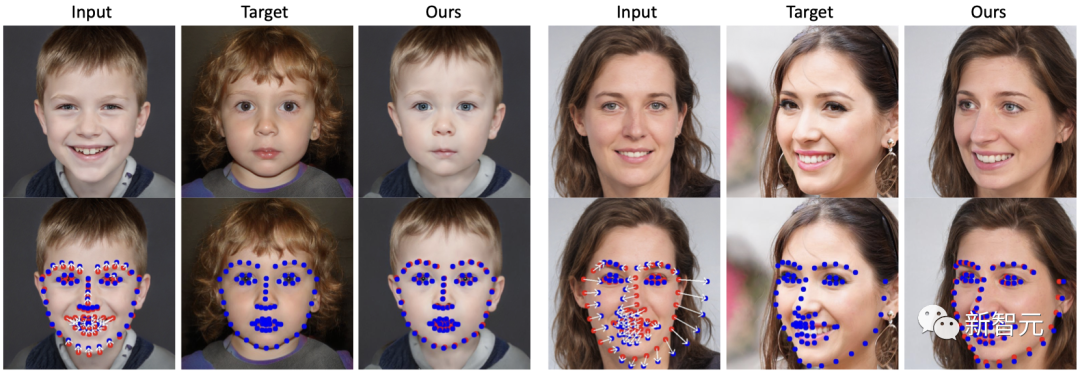

首先,与UserControllableLT相比,DragGAN能够编辑从输入图像中检测到的特征点,并使其与从目标图像中检测到的特征点相匹配,而且误差很小。

从下图中可以看出,DragGAN正确地张开了照片中人物的嘴,并调整了下巴的形状来匹配目标的脸型,而UserControllableLT未能做到这一点。

脸部特征点编辑

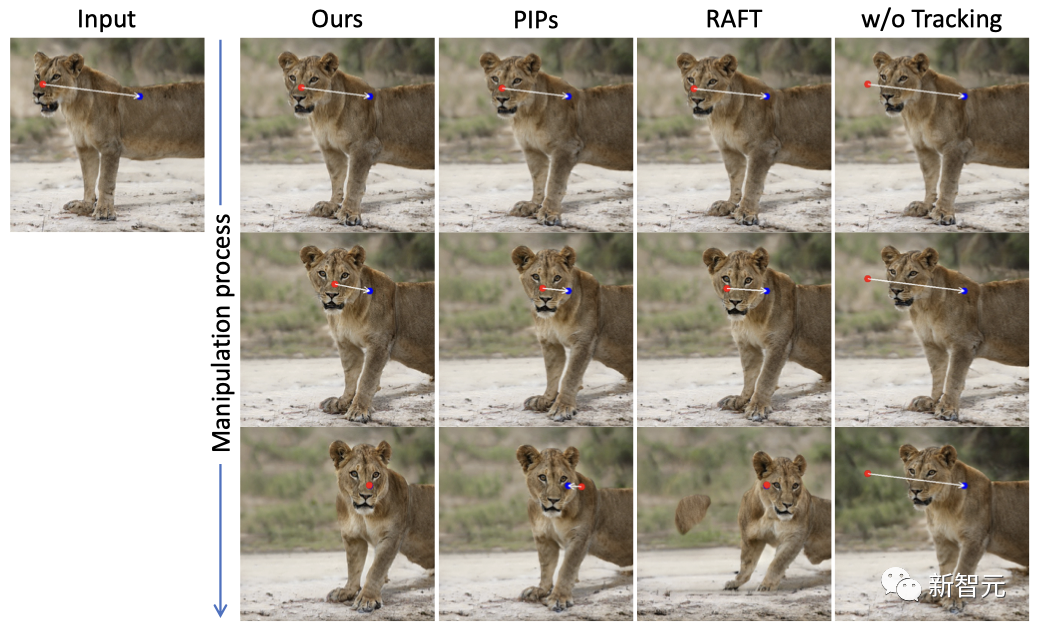

在DragGAN与RAFT、PIPs和无追踪的定性比较中,可以看得,DragGAN可以比基线更准确地跟踪操作点,进而能够产生更精确的编辑。

定性比较

而在移动操作点(红点)到目标点(蓝点)的任务上,定性比较的结果显示,DragGAN在各种数据集上都取得了比UserControllableLT更加自然和优秀的效果。

定性比较

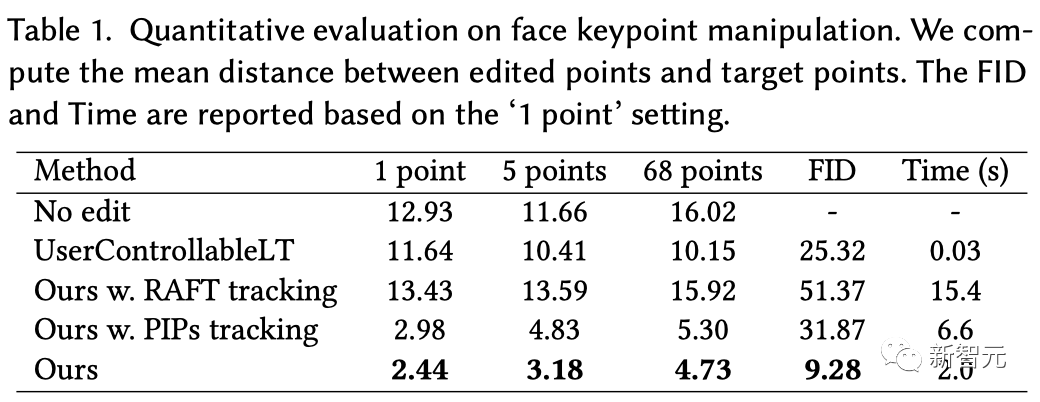

如表1所示,在不同的点数下,DragGAN都明显优于UserControllableLT。而且根据FID的得分,DragGAN还保留了更好的图像质量。

由于具有更强的跟踪能力,DragGAN还实现了比RAFT和PIPs更精确的操纵。正如FID分数所显示的,如果跟踪不准确的话,很可能会造成编辑过度,从而降低图像质量。

虽然UserControllableLT的速度更快,但DragGAN在很大程度上提升了这项任务的上限,在保持相对较快的运行时间的同时,实现了更靠谱的编辑。

定量分析

结果讨论

DragGAN是一种基于点的交互式图像编辑方法,该方法利用预训练的GAN来合成图像。其中,这些合成图像不仅精确地遵循了用户的输入,而且还能保持在真实图像的流形上。

此外,与之前的方法相比,团队提出的DragGAN还是一个通用框架,并不依赖于特定领域的建模或辅助网络。

这是通过两个新颖的组件来实现的,它们都是利用GAN的中间特征图的辨别质量,来生成像素精确的图像形变和交互性能:

1. 一个优化潜在代码的方法,逐步将多个操作点移向目标位置

2. 一个点追踪程序,真实地追踪操作点的轨迹

总结来说,全新的DragGAN在基于GAN的编辑方面要优于现有的技术,并为使用生成式先验的强大图像编辑开辟了新的方向。

至于未来的工作,团队计划将基于点的编辑扩展到3D生成模型。

模型局限

尽管具有一定的泛化能力,但DragGAN的编辑质量仍受训练数据多样性的影响。

如下图(a)所示,创建一个训练分布外的人体姿势,可能会生成错误的图像

此外,如图(b)(c)所示,在无纹理区域的操作点在追踪时有时会有更多的漂移。

因此,团队建议尽量去选择纹理丰富的操作点。

作者介绍

论文一作Xingang Pan,即将上任南洋理工大学计算机科学与工程学院MMLab@NTU的助理教授(2023年6月)。

目前,他是马克斯·普朗克计算机科学研究所的博士后研究员,由Christian Theobalt教授指导。

在此之前,他于2016年在清华大学获得学士学位,并2021年在香港中文大学多媒体实验室获得博士学位,导师是汤晓鸥教授。

Lingjie Liu

Lingjie Liu是宾夕法尼亚大学计算机和信息科学系的Aravind K. Joshi助理教授,负责宾大计算机图形实验室,同时也是通用机器人、自动化、传感和感知(GRASP)实验室的成员。

在此之前,她是马克斯·普朗克计算机科学研究所的Lise Meitner博士后研究人员。并于2019年在香港大学获得博士学位。

参考资料:https://vcai.mpi-inf.mpg.de/projects/DragGAN/