时隔 4 个月,Kimi 推出了旗下开源模型 K2 的推理版本——K2 Thinking 模型,Kimi 迄今为止最强的开源思考模型。

1T 参数,MoE 架构,32B 激活,原生 INT4 量化,256k 上下文,更好支持国产 GPU。

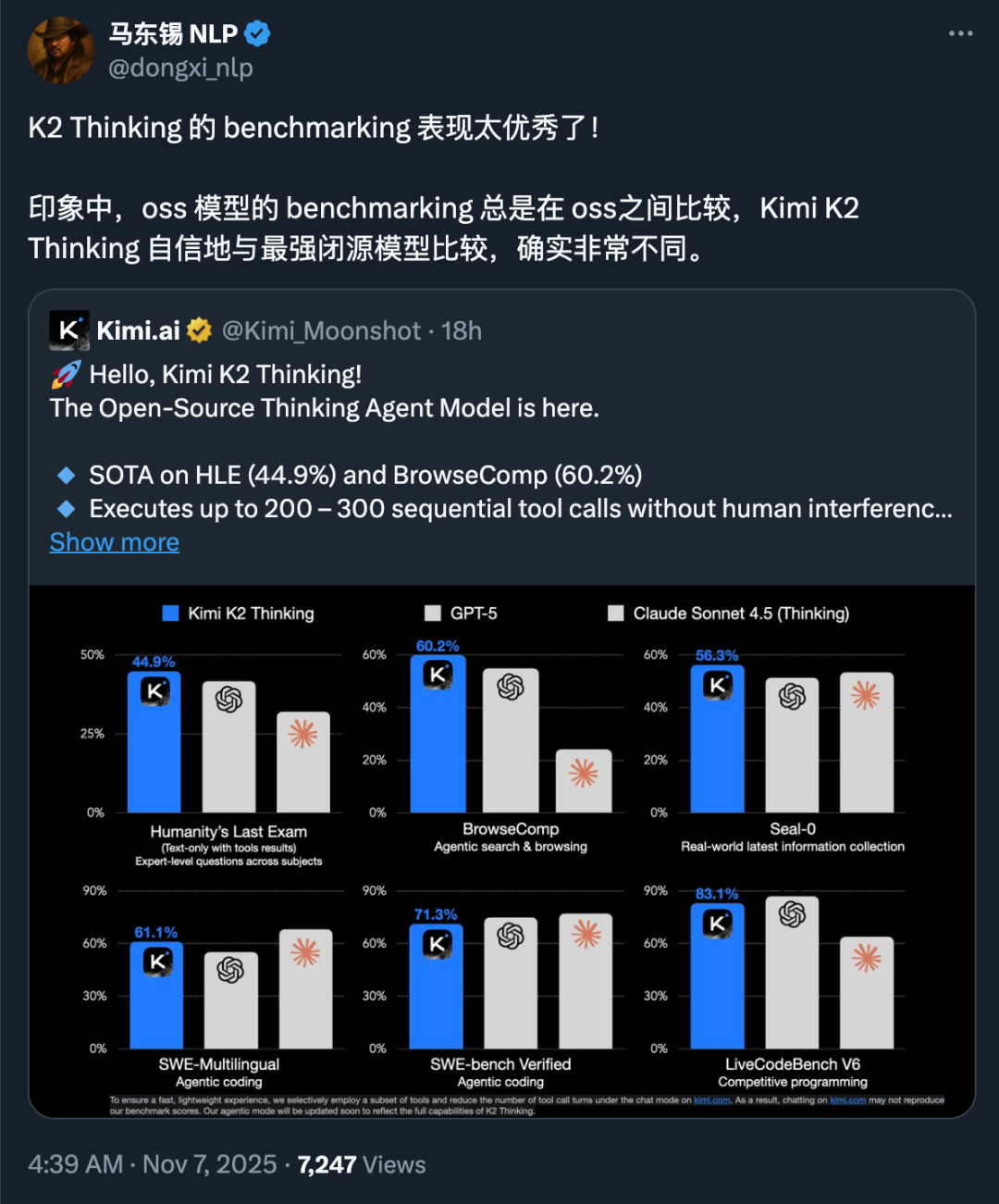

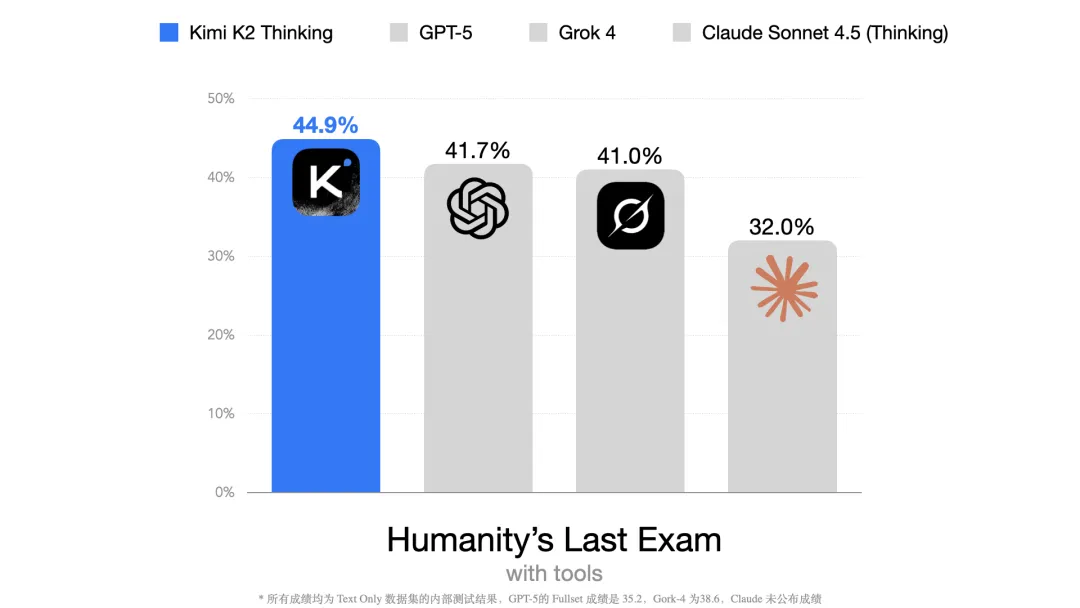

官方评测成绩显示,K2 Thinking 在「人类最后的考试」的评测中,多项基准测试的表现达到了 SOTA 水平,不仅仅是开源领域,K2 Thinking 的测试成绩超过了同类型闭源模型。

相比较 K2 模型,K2 Thinking 模型无需人工干预,可以自主实现高达 300 轮的工具调用和多轮思考能力,可以解决更复杂的问题。

回过头来看,从 K2 到 K2 Thinking,从「模型即 Agent」到「模型即 Thinking Agent」,Kimi 正依靠自己的独特技术思考和判断,在资源受限的情况下,走上追赶乃至超过欧美 AI 巨头的道路。

不管怎么看,都有点热血漫的即视感。

01

K2 Thinking,

人类最后考试的 SOTA 模型

正如姚顺雨在《AI 下半场》中所说,「人工智能的下半场——从现在开始——将把重点从解决问题转移到定义问题。在这个新时代,评估将比训练更重要。」

模型能力持续进步的当下,评估变得比以往更加重要。

在 NMLU、GPQA 等传统基准测试已经无法有效体现模型能力的时候,人类最后的考试(Humanity's Last Exam,简称 HLE)在 2025 年应运而生。这是一个旨在评估当下最厉害的大模型的能力的基准测试集。由 Center for AI Safety 和 Scale AI 联合创建,测试内容几经调整,最终在 2025 年 3 月 4 日确定为一套包含了 2500 个前沿学术难题的题库,这些题分布在 100 多个不同的学科领域,由 50 多个国家的近 1000 名学科专家贡献。

在允许使用工具——搜索、Python、网络浏览工具的同等情况下,针对 Text-Only 的数据集的测试结果中,Kimi K2 Thinking 在这项基准评测中取得了 44.9% 的 SOTA 成绩。

HLE 测试集最初发布时,旗舰模型的评测结果都不到 20%,到了今天大家基本都达到了超过 40% 的成绩,在数据的 Scaling Law 效果逐渐减小的当下,模型的能力确实还在一直进步中。

甚至有了开源模型超过闭源模型的一幕。

除去官方的演示测试外,我们也看到了「歸藏的 AI 工具箱」、「赛博禅心」等自媒体作者的评测,不只是代码能力增强了,更明显的是,解决问题的综合能力真的提升了。

02

当缸中之脑真正有了脚手架

回到 4 个月前,在 K2 初发布时,很多人的第一疑惑是——居然不是个推理模型?

在 DeepSeek R1 已经成为全球级的现象事件时,一款非推理模型的开源,能带来多大的反响呢?

Kimi 当时对外的回答是聚焦 Agent,做能更好调用工具的 Agent 模型。在我们与Kimi一位研究员的聊天中得知,其实在 K2 发布前,他们已经做过一个初版的 thinking 模型,但在 K2上线时,只先发布了 Agent 的前半截。

8 月份张小珺对杨植麟的采访中,杨植麟在他认为的两种模型范式中,选择了后者。

「一种是长思考的推理模型(Reasoning Model),以 o1 作为第一个做出来的代表。本质上,它通过让模型在过程中做很多尝试和反思,反思是其中重点。但它还是一个『缸中之脑』(brain in a vat),并不需要跟外界交互。」

「但有另一个很重要的范式,就是基于多轮的 Agent(智能体)强化学习范式,或者通过强化学习技术训练出来的 Agentic 模型,它的特点是会跟外界做很多交互。」

「但这两个东西都指向了同一个东西,是:test-time scaling(测试时扩展)。意思是,可以在测试时,或者在推理时,做到更好的规模化。」

Kimi 当时选择了第二种方式,先做「交互」,然后再做「反思」,也就是今天的 K2 Thinking。

一个有了脚手架的「缸中之脑」,用杨植麟的话说,「它可能是一个从『缸中之脑』变成可以跟世界交互,因为所谓 Agent 最重要的特征,就是它可以多轮地使用工具。

有两个关键点:一个是多轮,一个是工具。

多轮就是你能做很多次,是 test time scaling(测试时扩展)的一种方式;工具则是连接这个『脑』跟外部世界的方式。」

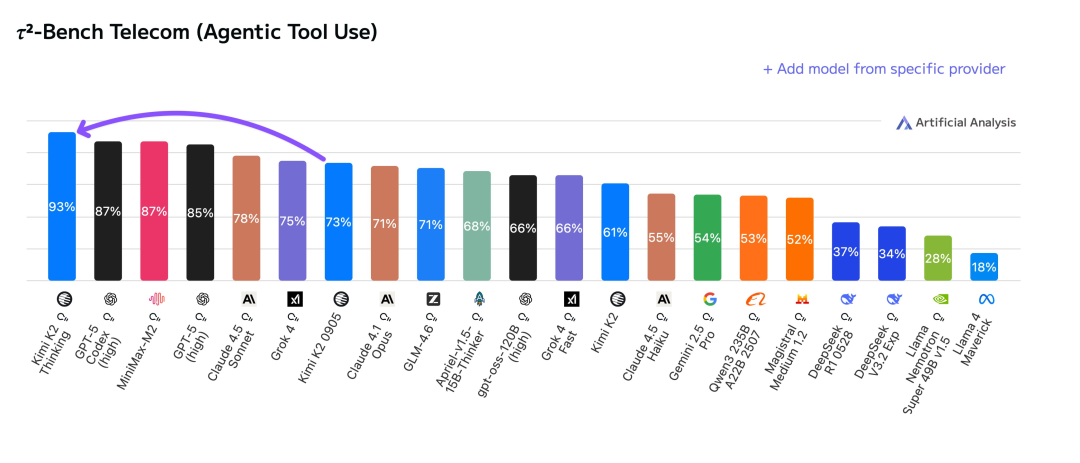

K2 Thinking 调用工具的能力有进一步提升

当「缸中之脑」有了脚手架,模型的能力有了质的提升。所以才有了自主实现 300 轮工具调用和多轮思考的能力,实现了更强的 Agent 和推理性能。

到了这一步,OpenAI 此前所设置的 AI 从 L1-L5 的分级,L3(Agent 智能体)可能才真的看到了曙光。

有趣的是,在 K2 Thinking 的 API 调用说明中可以看到,模型的多步工具调用,需要把上下文中所有的思考内容(reasoning_content 字段)返回给模型进行多次推理,保持推理的连贯性。

类似这样的能力,是 Claude 的「extended thinking」(扩展思考),同样也是支持把推理结果持续带入后续步骤。

在当下,这是一种非共识的技术思路,OpenAI 的 GPT 系列和 Google 的 Gemini 模型都没有支持这个功能。

03

资源悬殊下的逆风局

在 K2 Thinking 模型发布后,我们在 X(推特)上看到了一张有趣的图。

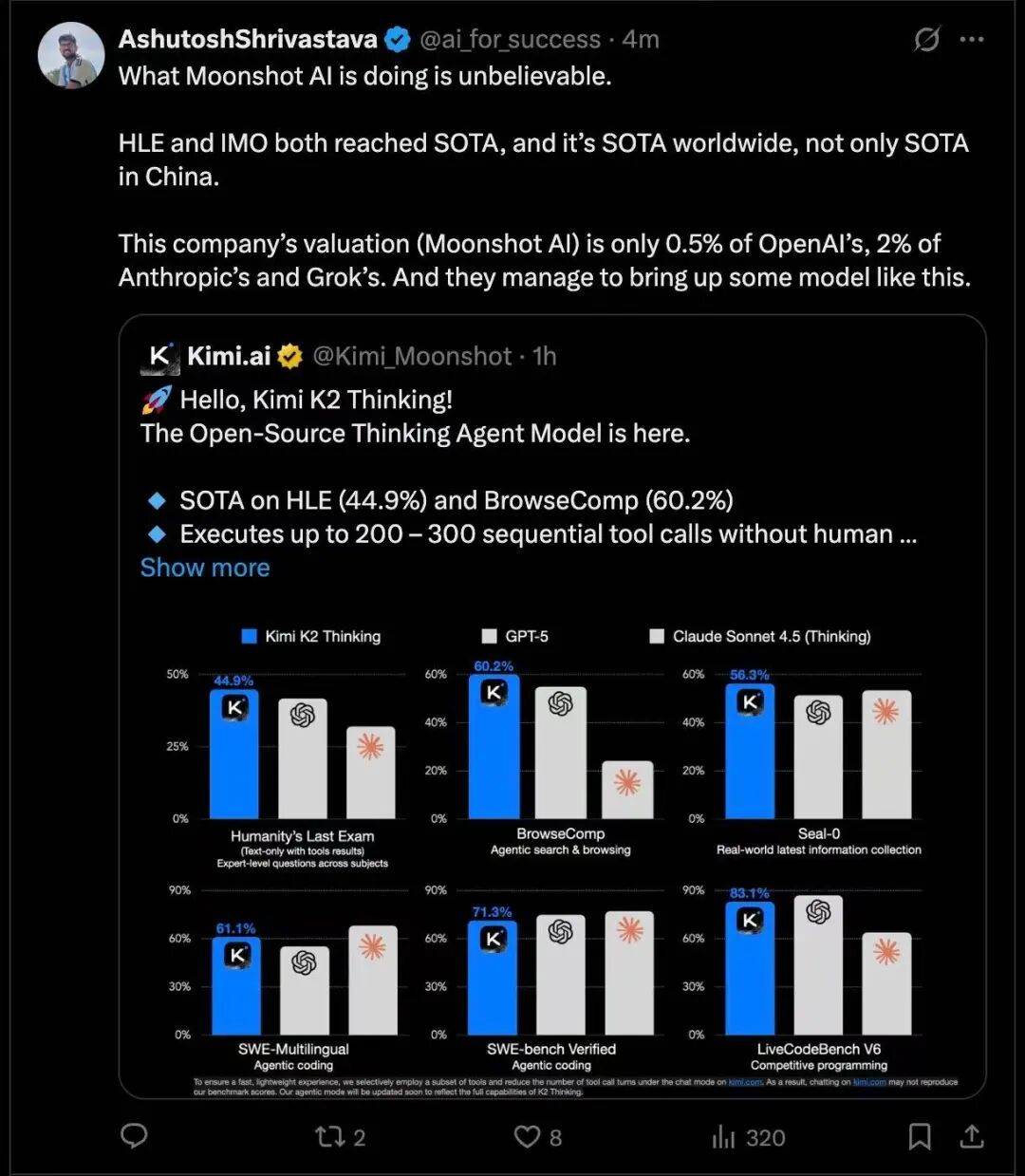

按照这位博主的说法,在 HLE 上达到了全球 SOTA 能力的 K2 Thinking,所属公司月之暗面目前的估值是 OpenAI 的 0.5%,是 Anthropic 和 Grok 的 2%。

或者我们可以用更详细的一个数据来进一步对比。

Kimi 去年的估值是 33 亿美元,即便算上最近传言中的新融资,推算新估值仍在几十亿美元级别。

而马斯克的 Grok(xAI),截至 2025 年 9 月底,估值约为 2000 亿美元。可以顺便看看另外两家的估值情况,在完成今年 9 月份 F 轮 130 亿美元的融资后,Anthropic 目前的估值是 1830 亿美元;OpenAI 最新的估值是 5000 亿美元,成为全球最具价值的私营公司之一。

与此同时,xAI 拥有目前全球规模最大的 GPU 集群之一——20 万块 H100 GPU 的 Colossus 超级计算机集群,员工总数超过 1200 人,据估计 Grok 4 的训练成本可能达到了 4900 万美元。

而 Kimi,公司人数 200 人左右,据外媒报道,训练成本约 460 万美元。

对中国的基模公司来说,都面临「缺显卡」、资源相对稀缺的现状,融资太少、卡太贵。与 OpenAI、Google 等美国巨头相比,试错机会少、成本压力大。要想活下来,必须精确地把每一步的执行都做对。K2 Thinking在多轮思考和调用工具的能力上超过GTP5、Grok4等国外闭源模型,让中国 AI 创业公司用不到 1% 的资源,完成了对万亿巨头的逆风翻盘。

未来,是否会像黄仁勋对《金融时报》所说的那样,「中国将在人工智能竞赛中击败美国」,局势正在改变。