作者简介

何辰轩,中国人民大学统计与大数据研究院博士研究生。

探索学科内的新兴知识趋势,是科研人员理解历史发展、把握未来方向的重要途径。今天和大家分享近期在Journal of the American Statistical Association发表的一篇文章。该文章聚焦统计学领域,提出了一种协变量辅助动态主题模型(CDTM),用于分析统计学顶级期刊和会议论文,揭示统计学研究过去四十年的演进轨迹及新兴热点。研究同时发现,一些统计主题正日益与人工智能的发展紧密结合,为未来的创新研究提供了部分参考。文章的详细信息如下:

Chenxuan He, Feifei Wang, Liping Zhu.(2026). Emerging Knowledge Trend in Statistical Research:A Content-Based Analysis using Covariate-Assisted Dynamic Topic Model, Journal of the American Statistical Association.

https://doi.org/10.1080/01621459.2025.2602833

01

背景介绍

学科的研究兴趣总是在不断演变,这一变化受技术进步、社会需求以及新兴挑战的驱动。理解这些变化对于科研人员至关重要,因为它能够帮助他们掌握学科内的关键发展动态。在本研究中,我们聚焦于发展最快的学科之一——统计学,该学科起源于19世纪末和20世纪初。在过去的一个世纪中,统计学衍生出了许多分支,包括高维数据分析、时间序列分析、贝叶斯分析、回归方法、变量选择、实验设计以及半参数与非参数理论等。统计学也与其他学科深度融合,例如生物与医学科学、经济学及金融学。近年来,统计学进入了人工智能(AI)时代,越来越多的子领域与数据科学紧密相关。因此,探索统计学的发展趋势与新兴研究主题具有重要意义。

探索某一学科的新兴知识趋势的一种方法是分析该学科顶级期刊的论文。发表的文章可以反映最受关注和最活跃的研究主题,这些主题通过不同形式的引用相互联系。因此,顶级期刊的发表论文可用于研究特定学科的新兴知识趋势。由于这些论文大多是非结构化的文本数据,因此可以采用专门针对文本挖掘的技术进行分析。为此,一类经典方法是主题模型(Topic Models),其目标是从文档集合中发现潜在主题。基础的主题模型是潜在狄利克雷分配(LDA, Blei et al., 2003),它假设每篇文档遵循一组主题的分布,每个主题又遵循词汇表的分布。基于这些假设,可以建立并估计一个三层概率模型。总体来说,主题模型的核心优势在于能够用一个低维且可解释的向量表示文档,即文档的主题分布。近年来,随着人工智能的发展,神经主题模型(Neural Topic Models)和大型语言模型(LLMs)在文本挖掘中变得越来越流行。尽管 NTMs 和基于 LLMs 的方法在文本分类、信息检索等下游任务中表现出色,但它们的训练通常需要大量数据和计算资源。通过提示(prompt)将 LLMs 应用于特定任务似乎是一个简便方法,但其结果往往缺乏一致性与透明性。此外,这些方法通常无法为文本内容提供量化且可解释的表示。相比之下,概率主题模型能够提供可解释且可量化的文本表示,从而实现结构化分析与推断。 Lin et al.,(2025)也发现,作为 LLMs 的代表,ChatGPT 最终仍回归使用传统统计方法进行主题建模。因此,在本研究中,我们依然依赖概率主题模型来探索统计学的新兴知识趋势,同时借助 LLMs 辅助分析。关于方法的更多讨论可参见附录材料。

为了从已发表文章中研究新兴知识趋势,我们的初步分析表明,协变量在其中起到了关键作用。这是因为论文主题通常受多种因素影响,例如作者和发表刊物。与理论主题相比,涉及实际应用的主题通常作者数量更多;不同刊物可能有各自的偏好或风格,从而导致主题倾向不同。因此,在本研究中,我们引入协变量信息来探索统计学的知识趋势,并提出协变量辅助动态主题模型(Covariate-assisted Dynamic Topic Model, CDTM)。具体而言,我们利用高斯过程(Gaussian process)建模主题随时间在词汇上的动态分布,并通过逻辑回归框架将协变量对文档主题分布的影响纳入模型,同时允许协变量效应随时间变化。我们通过变分推断(variational inference)对 CDTM 进行估计,在理论上证明了在正则条件下估计量的一致性,并通过模拟文档展示其经验性能。最后,我们将 CDTM 应用于统计学顶级期刊和相关会议的论文,以探究过去几十年统计学知识的演进趋势。具体来说,我们希望回答下述问题:

(Q1)在过去的四十年里,统计研究中的关键主题和方法上的进步是如何演变的?

(Q2)面对人工智能的兴起,统计学领域是如何发展的?历史研究的进展与现在数据科学、人工智能之间又有着怎样的联系?

(Q3)协变量(如发表的期刊、作者的合作模式)在统计研究趋势方面起到了怎样的作用?

02

数据与描述分析

2.1 数据收集:覆盖统计学与AI的交叉地带

我们收集了统计学四大顶级期刊以及与统计学相关性较高的三个AI会议的数据。其中:选取的统计学四大顶级期刊包括 Journal of the American Statistical Association(JASA)、Annals of Statistics(AOS)、Journal of the Royal Statistical Society Series B(JRSSB)、Biometrika(BKA)。选取的三个与统计学相关性高的AI会议包括International Conference on Artificial Intelligence and Statistics(AISTATS)、International Conference on Machine Learning(ICML)、Conference on Neural Information Processing Systems(NeurIPS)。

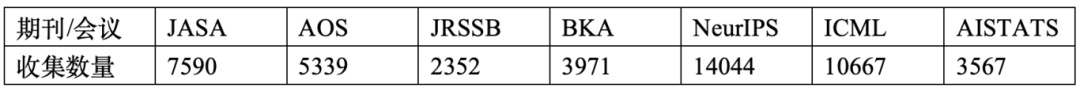

具体而言,我们收集了自1980年至2024年发表在四个期刊上的文章,以及2014年至2024年发表在三个会议上的文章。各期刊/会议的论文数量如下:

表1:收集的论文数量(期刊年度为1980–2024;会议年度为2014–2024)

由于三个会议不仅包含统计相关论文,还有大量与机器学习和AI领域的文章,我们首先对会议论文进行预筛选,目标是从这三个会议中挑选出与统计学相关度高的文章。我们采取如下的筛选方法:(1)使用 BERT(Devlin, Chang, Lee & Toutanova 2019)将期刊和会议文章的标题转换为向量表示形式,(2)计算四个统计学期刊中文章的平均向量,作为统计学研究的代表向量,(3)测量每篇会议论文的向量与四本期刊的平均向量之间的余弦相似度。我们发现,不同会议论文与统计期刊论文的余弦相似度各不相同,前30%的分位数大致对应于众数区域。因此,我们在分析中选择了最相关的约30%的会议论文纳入研究分析中。其中, NeurIPS 中有 4285 篇(占其总论文的约31%),ICML 中有 2750 篇(占其总论文的约26%),AISTATS 中有 1448 篇(占其总论文的约41%)。按照这种方法筛选出来的数据既覆盖了统计学的核心期刊,又纳入了AI领域与统计交叉的前沿成果,为全面分析统计学的演变提供了坚实基础。

2.2 论文发表数量分析

我们首先讨论论文发表数量的变化(见图1)。自2010年以来,三个与统计学相关的AI会议的年产出呈指数增长,而同期四个统计期刊的出版数量保持相对稳定。这一关键差异在于AI会议与统计期刊不同的编辑政策:三个会议的论文接收率通常维持在 20%–30% 之间。相比之下,统计学期刊往往力图保持每年相对固定的发表数量,这使得它们在投稿量增加的情况下变得愈发严格。例如,JRSSB 在 1990 年大约收到 200 篇投稿,接收率约为 25%(Kent & Smith 1991);到 2020 年,投稿量已上升至约 600 篇,而接收率则下降至约 8%(Delaigle & Wood 2021)。这一趋势并非 JRSSB 独有, JASA 在近几年报告的接收率也约为 10%(American Statistical Association 2022)。与计算机科学会议相对较高的接收率相比,统计学期刊较低的接收率已导致一个日益明显的趋势,即越来越多的重要研究成果转向在计算机科学会议上发表。

图1:各期刊/会议论文发表数变化(1980–2024,对数尺度)

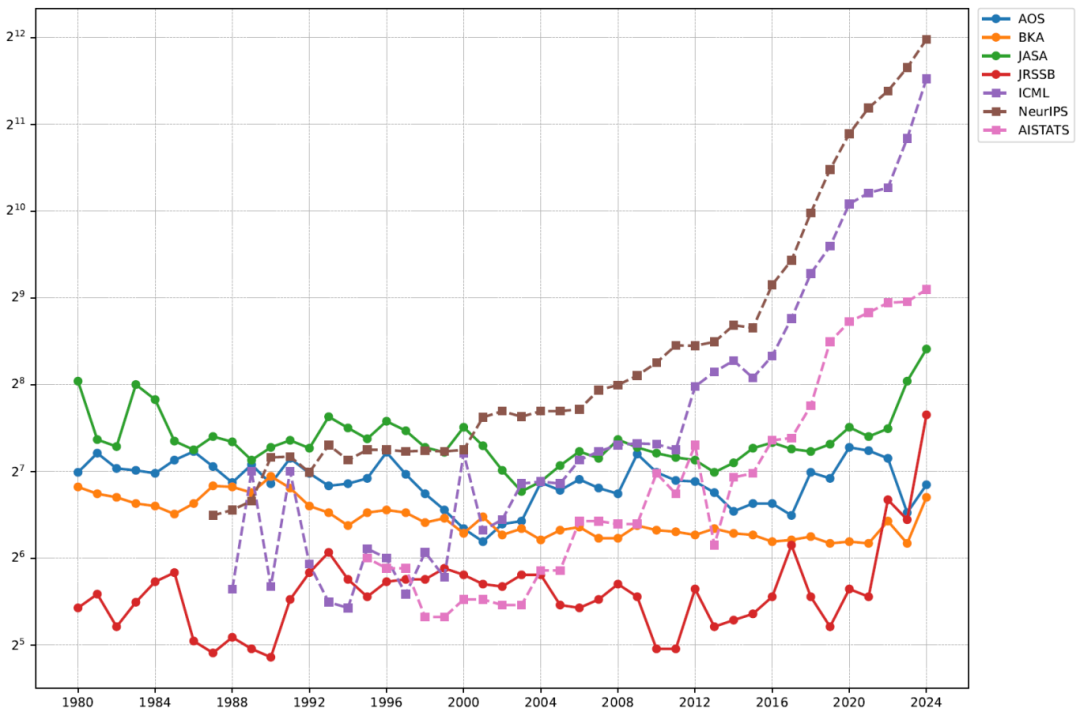

2.3 影响因子变化

图2显示了Clarivate(科睿唯安)报告的四个统计期刊的影响因子。结果显示,影响因子随时间有所波动,但总体趋势呈现普遍上升轨迹,表明这些期刊在学术界的影响力和认可度逐渐增加。不过值得注意的是,Clarivate提供的影响因子只计算期刊之间的互相引用。AI会议既没有影响因子,它们的引用也不会计入其他期刊的影响因子的计算。

图2:统计学四大顶级期刊影响因子变化(2000–2024)

2.4 高被引论文分析

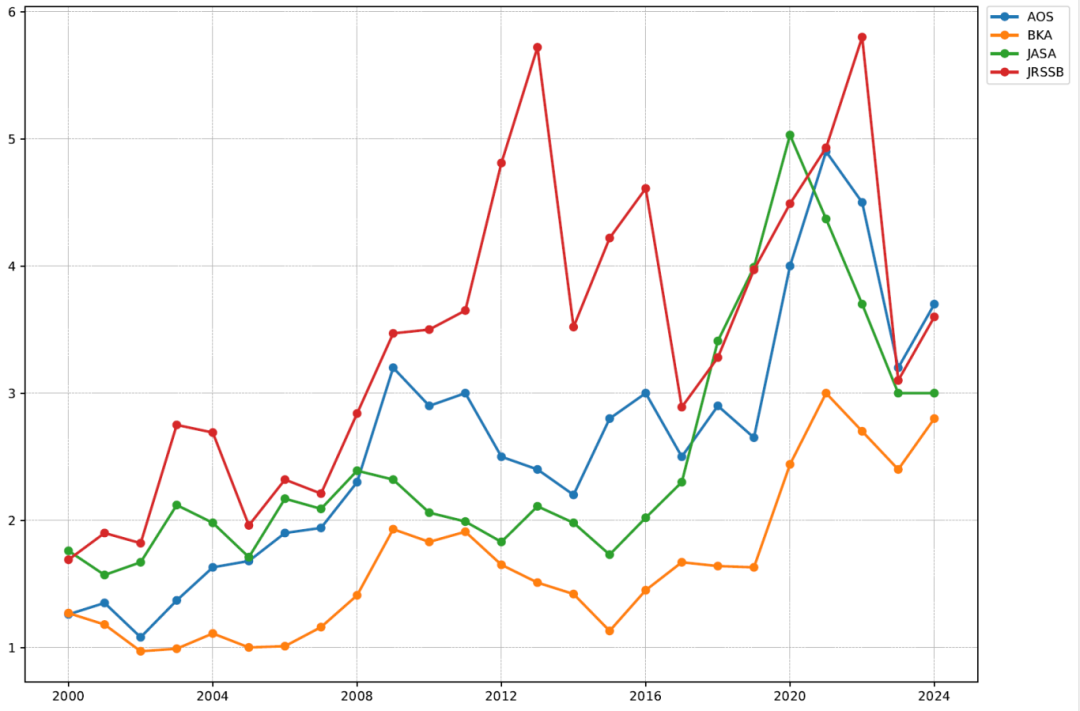

Nature在2025年发表的一篇论文分析了21世纪全科学领域高被引论文的情况(Pearson, Ledford, Hutson & Van Noorden 2025)。在此启发下,我们也看看统计学四大顶级期刊发表的论文中高被引论文的情况。基于Google Scholar的引用数据,我们梳理了两个时期的高引论文,勾勒出统计学的演变轨迹。

第一阶段:1979年-2014年——理论与方法的黄金年代

在这个时期,统计学完成了从经典理论向现代方法的转型。我们找出了这个时期内Google Scholar引用次数超过10000次的20篇论文,详见表2。其中,引用数最高的为 Benjamini & Hochber(1995)提出的虚假发现率(FDR)控制方法,累计引用超过12万次,年均4000+引用。这篇论文解决了多重假设检验中的核心问题,至今仍是该领域的必读文献。

表2:1979–2014年统计学四大顶级期刊高引用文章(Google Scholar统计截止时间为2025年10月25日,不包含综述论文,按总引用数降序排列)

这个时代还涌现了众多基础性方法创新,例如:

➢ 稀疏统计和高维数据分析相关方法,包括

■ LASSO(Tibshirani 1996, JRSSB)超过6万次引用

■ SCAD(Fan & Li 2001, JASA)超过1万次引用

■ Elastic net(弹性网,Zou & Hastie 2005, JRSSB)超过2万次引用

➢ Bootstrap(Efron 1979, AOS)2.8万引用——重采样方法的里程碑,让统计推断不再依赖严格的分布假设

➢ 因果推断领域的倾向评分(Rosenbaum & Rubin 1983, BKA)超过4万引用

➢ 马尔可夫链蒙特卡罗MCMC(Gelfand & Smith 1990, JASA)超过1万引用,是贝叶斯计算的革命性突破

这个时代的特点是,这些论文奠定了现代统计学的理论和计算基础,其影响力跨越生物、医学、经济、金融等多个学科,成为各领域数据分析的标准工具。

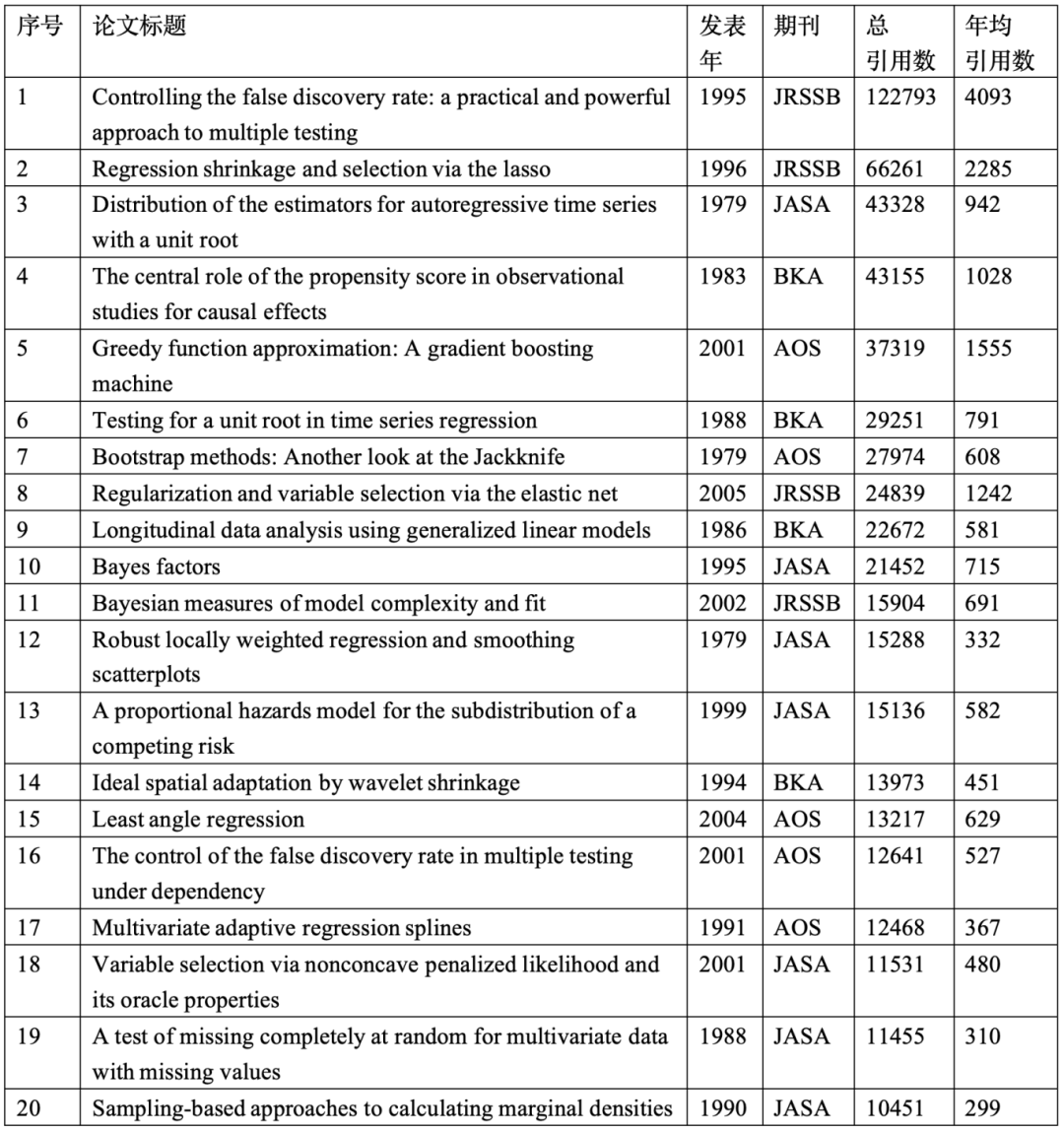

第二阶段:2015-今——与AI融合,从理论创新到回应挑战

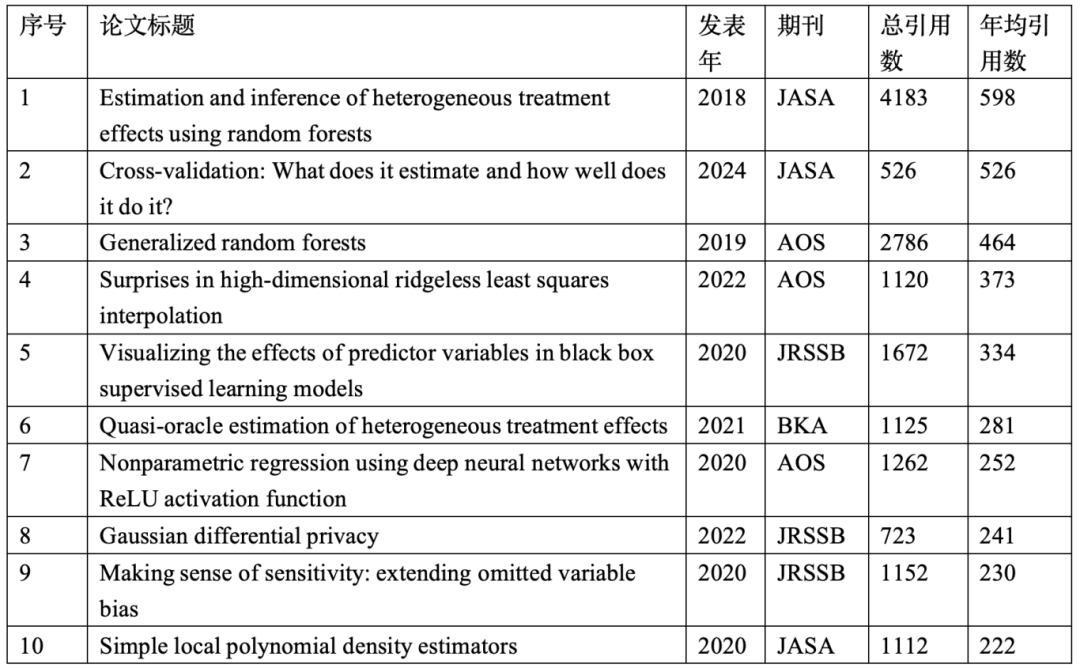

进入大数据和AI时代后,统计学的研究重心也发生了一定变化。在统计高被引论文时,由于年份较近,为了更公平地比较不同年份的论文,我们使用“年均引用次数”作为指标,得到表3年均引用数前10的论文。

表3:2015–2024年统计学四大顶级期刊高引用文章(Google Scholar统计截止时间为2025年10月25日,不包含综述论文,按年均引用数降序排列)

我们发现,近期高引论文呈现出三大新趋势:

趋势1:可解释AI成为核心议题

✓ 黑箱模型可视化(Apley & Zhu 2020, JRSSB):年均300+次引用——为复杂模型提供直观的解释工具

✓ 深度神经网络理论(Schmidt-Hieber 2020, AOS):年均200+次引用——为深度学习提供严格的非参数理论

✓ 高维“无脊”(ridgeless)最小二乘(Hastie, Montanari, Rosset & Tibshirani 2022, AOS):年均200+引用——为神经网络中双下降现象(“double descent”,即测试误差出现两次下降的情况)提供解释

✓ 使用黑盒模型解决因果推断的问题(Wager & Athey 2018;Athey, Tibshirani & Wager 2019;Nie & Wager 2021)

趋势2:经典方法的现代化应用或改造

✓ 交叉验证新论(Bates, Hastie & Tibshirani 2024, JASA):年均500+次引用——重新审视这一经典方法,回答它“到底估计了什么?效果如何?”

✓ 基于局部多项式的非参数密度估计(Cattaneo, Jansson & Ma 2020, JASA):年均200+次引用

✓ 因果森林(Wager & Athey 2018, JASA):年均500+次引用——将随机森林与因果推断结合,估计异质性处理效应

✓ 广义随机森林(Athey, Tibshirani & Wager 2019, AOS):年均400+次引用——进一步推广因果森林框架

✓ 因果推断中异质情况的估计方法(Nie & Wager 2021, BKA):年均200+引用

趋势3:AI时代下,隐私问题、分布式学习等领域的兴起

✓ 高斯差分隐私(Dong, Roth & Su 2022, JRSSB):年均200+次引用——在数据隐私保护方面的重要进展

✓ 分布式学习(Jordan, Lee & Yang 2019, JASA):年均100+引用,虽未进入Top 10,但引用增长迅速——反映大规模数据处理的现实需求

03

CDTM方法介绍

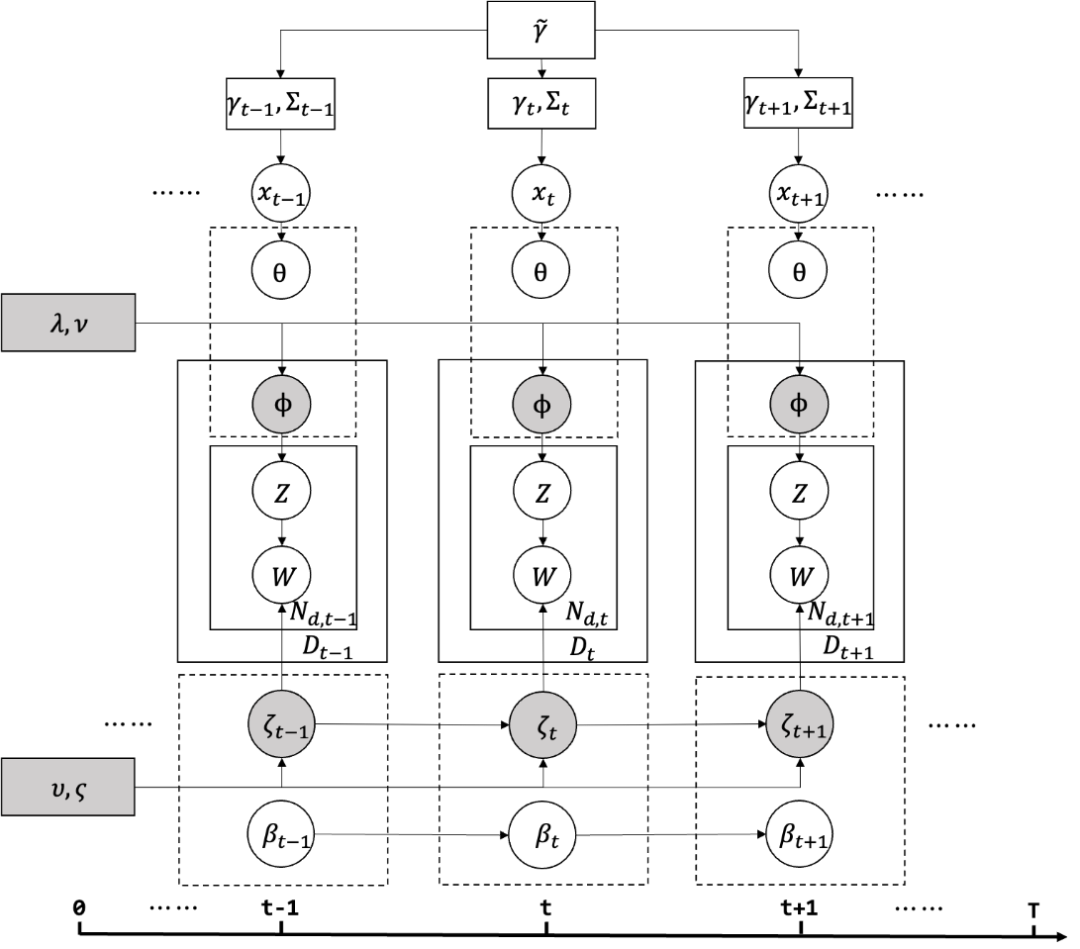

为了系统地理解统计学的演变,我们提出了协变量辅助的动态主题模型(Covariate-Assisted Dynamic Topic Model, CDTM)。这就像给每篇论文自动打上“主题标签”,然后追踪这些“标签”在40年间的起伏变化。该模型的核心思想是:将每篇论文看作多个主题(参数θ)的混合,这个主题分布的向量θ可以被协变量x影响;每个主题再由一个词分布的向量(参数 β)控制,这个词分布会随着时间的推演变化。CDTM的模型框架图具体见图3。

图3:协变量辅助的动态主题模型示意图

通过变分推断的方法提取每个文档的潜在主题分布以及每个主题的潜在词分布,追踪这些主题在时间上的演变以及不同协变量(如期刊、会议、作者数等)对主题的影响。在模拟数据和真实数据上,CDTM的主题质量指标均显著优于动态主题模型DTM(Blei & Lafferty 2006)、结构主题模型 STM (Roberts, Stewart & Airoldi 2016)等经典方法。方法的详细介绍请参考论文原文。

04

实证分析

4.1 CDTM建模

我们将所提出的协变量辅助动态主题模型(CDTM)应用于统计学文献数据集。为刻画主题随时间的动态变化,我们根据发表年份将数据集划分为 45 个时间片,覆盖 1980—2024 年。我们考虑以下协变量:出版物(7个类别)、作者数量(连续变量)。

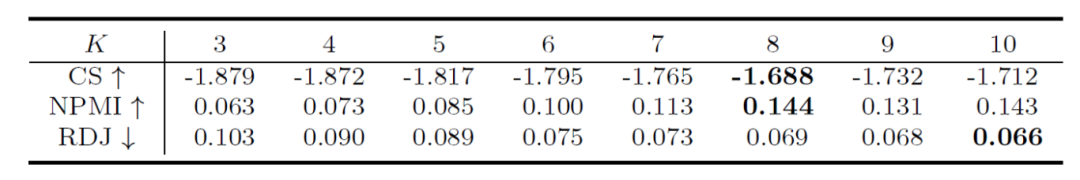

在建模之前需要确定主题个数K。为此,我们考虑一系列主题数的选择,然后采样三种常用评价指标进行模型评估。前两种指标为一致性得分(coherence score, CS)和归一化点互信息(normalized pointwise mutual information, NPMI),用于衡量每个主题中高频词的语义一致性。CS 或 NPMI 值越高,表明主题内词汇在语义上越相关、可解释性越强。第三个指标为改进多样性 Jaccard 指数(refined diversity Jaccard index, RDJ),用于衡量不同主题之间的多样性,即评估主题间词汇重叠程度。RDJ 值越低,说明主题区分度越高、冗余性越低。不同主题数下的CDTM的表现见表3. 结果表明,CS和NPMI在K=8时达到最大值,而RDJ在K=10时取得最小值,但相较于K=8仅有边际改进。综合上述权衡,我们最终选择K=8作为 CDTM 的最优主题数。

表 4:不同主题数下的主题评价指标。向上箭头表示该指标数值越大越好,向下箭头表示该指标数值越小越好。加粗表示最优结果

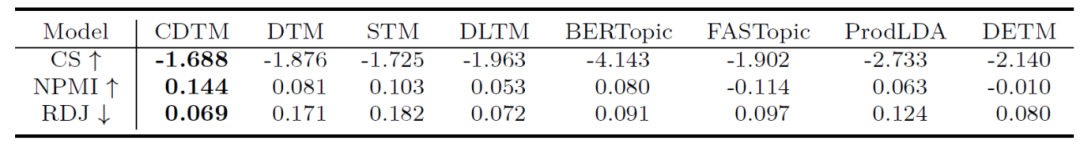

我们进一步将 CDTM 与七种对比方法进行了比较:(1)动态主题模型(DTM,Blei & Lafferty 2006),(2)结构主题模型(STM,Roberts et al. 2016),(3)动态线性主题模型(DLTM,Glynn et al. 2019),(4)BERTopic 模型(Grootendorst 2022),(5)FASTopic 模型(Wu et al. 2024),(6)ProdLDA 模型(Srivastava & Sutton 2017),以及(7)动态嵌入主题模型(DETM,Dieng et al. 2019)。其中,DTM、STM 和 DLTM 属于贝叶斯主题模型;DETM 为动态神经主题模型;BERTopic 和 FASTopic 为基于 Transformer 的神经主题模型;ProdLDA 则是基于变分自编码器(VAE)的神经主题模型。由于 BERTopic 不支持用户显式指定主题数,我们通过调节相关参数使其产生K=9个主题,以获得与 CDTM 中K=8的设置最为可比的结果。其余模型均在真实数据集上运行,并将主题数固定为 $K=8$。表 5 汇总的结果表明,CDTM 在三项评价指标上均表现出更优的性能。CDTM 与上述方法的详细比较见论文补充材料。

表 5:不同模型的主题评价指标。向上箭头表示该指标数值越大越好,向下箭头表示该指标数值越小越好。加粗表示最优结果

4.2 主题含义

本节我们重点关注CDTM提取出的主题含义。模型一共挖掘出8个主题,可以根据每个主题下所有词的概率分布以及出现的高概率词对主题含义进行总结。与此同时,我们还借助大语言模型(LLMs)来辅助总结各主题的含义。具体而言,我们向 ChatGPT 提出如下问题:“Here are several key words from a series of articles in statistics. Can you help me summarize the topic of these articles in a few concise words?” 并将其给出的回答作为主题的总结描述。每个主题的含义总结如下。

✓ 主题1:算法与优化(Algorithm and Optimization)

➢ 代表性关键词:EM算法(EM algorithm)、随机梯度(stochastic gradient)、凸优化(convex optimization)、原对偶(primal dual)、强凸性(strongly convex)、随机逼近(stochastic approximation)

➢ 典型论文:

■ 约束马尔可夫决策过程的近优样本复杂度(Vaswani, Yang & Szepesvari 2022, NeurIPS)

■ 一个不等概率抽样方案(Saxena, Singh & Srivastava 1986, BKA)

➢ 主题解读:涵盖了统计计算的核心算法,从经典的EM算法到现代的随机优化方法。

✓ 主题2:贝叶斯统计(Bayesian Statistics)

➢ 代表性关键词:先验(prior)、后验(posterior)、不确定性量化(uncertainty quantification)、随机效应(random effect)、高斯过程回归(Gaussian process regression)、MCMC

➢ 典型论文:

■ 贝叶斯预测信息准则(Ando 2007, BKA)

■ 广义线性和加性多层模型的投影预测推理(Catalina, Bürkner & Vehtari 2022, AISTATS)

➢ 主题解读:贝叶斯推断及其在层次模型、不确定性量化中的应用。

✓ 主题3:深度学习(Deep Learning)

➢ 代表性关键词: 神经网络(neural network)、架构(architecture)、表示学习(representation)、Transformer、迁移学习(transfer learning)、元学习(meta learning)

➢ 典型论文:

■ 图表示学习的方向扩散模型(Yang, Yang, Zhou & Sun 2023, NeurIPS)

■ 耦合生成方法(Coupled generation)(Dai, Shen & Wong 2022, JASA)

➢ 主题解读: 统计学对深度学习的理论研究和方法创新,这是近十年增长最快的主题。

✓ 主题4:生物统计(Biostatistics)

➢ 代表性关键词: 测量(measurement)、干预(intervention)、乳腺癌(breast cancer)、中介变量(mediator)、死亡率(mortality)、生存分析(survival analysis)

➢ 典型论文:

■ GWAS中的遗传相关性估计(Zhao & Zhu 2022, JASA)

■ 线性结构因果模型的敏感性分析(Cinelli et al. 2019, ICML)

➢ 主题解读: 生物医学应用中的统计方法,包括生存分析、临床试验、基因组学等。

✓ 主题5:非参数统计(Nonparametric Statistics)

➢ 代表性关键词: 密度估计(density)、核方法(kernel)、收敛速度(rate of convergence)、带宽选择(bandwidth selection)、流形(manifold)、再生希尔伯特空间(RKHS)、oracle不等式(oracle inequality)

➢ 典型论文:

■ Wasserstein GAN的极小极大最优性(Stéphanovitch, Aamari & Levrard 2024, AOS)

■ Rényi散度的非参数估计(Krishnamurthy, Kandasamy, Poczos & Wasserman 2014, ICML)

➢ 主题解读: 不依赖参数假设的统计推断方法,理论性较强。

✓ 主题6:回归分析(Regression)

➢ 代表性关键词: Lasso、分位数回归(quantile regression)、广义最小二乘(generalized least square)、充分降维(sufficient dimension reduction)

➢ 典型论文:

■ 多协变量异方差线性模型的推断(Cattaneo, Jansson & Newey 2018, JASA)

■ 基于阈值评分函数估计的高维非高斯单指标模型(Yang, Balasubramanian & Liu 2017, ICML)

➢ 主题解读: 各类回归方法,从经典线性回归到高维稀疏回归。

✓ 主题7:无监督学习(Unsupervised Learning)

➢ 代表性关键词: 聚类(cluster)、梯度流(gradient flow)、微分方程(differential equation)、采样(sampling)、变分自编码器(variational auto-encoders,VAE)

➢ 典型论文:

■ 理解VAE的实例可解释性(Kong & Chaudhuri 2021, NeurIPS)

■ 隐马尔可夫模型的子空间估计和预测方法(Andersson & Rydén 2009, AOS)

➢ 主题解读: 无标签数据的模式发现,包括聚类、降维、流形学习等。

✓ 主题8:其他主题(Others)

➢ 代表性关键词: 多重检验(multiple testing)、实验设计(experimental design)、特征筛选(feature screening)、极值理论(extreme value theory)、精度矩阵估计(precision matrix estimation)等

➢ 主题解读: 多个传统统计分支的集合。

值得注意的是,一篇文章通常不会专注于单一主题,而是涵盖多种主题,这一点在每个文档的主题参数 θ 中有体现。例如,一些使用神经网络进行非参数回归、分析非参数收敛速率的论文,主要包含主题3(深度学习)、主题5(非参数统计)和主题6(回归分析),如Schmidt-Hieber(2020)和 Jiao, Shen, Lin & Huang(2023)。

从所获得的主题中,我们可以观察到,在人工智能时代到来之际,统计学越来越关注与人工智能密切相关的议题。例如,主题3(深度学习)作为现代数据科学的核心要素,已成为统计学中一个新兴的研究领域。同时,许多统计学中的经典主题与数据科学紧密相连。例如,主题6(回归分析),作为统计学中的基本方法,在数据科学的预测建模中得到了广泛应用。此外,主题2(贝叶斯统计学)与现代机器学习方法中的概率推断密切相关,特别是在深度学习和强化学习中。因此,我们可以看到,经典的统计理论随着现代数据科学带来的挑战而不断发展,推动了各个领域的创新和进步。

4.3 主题热度变化

通过分析每个主题在不同时期的占比(即主题讨论热度)可以有些有趣的发现。下面以其中四个主题为例进行说明。

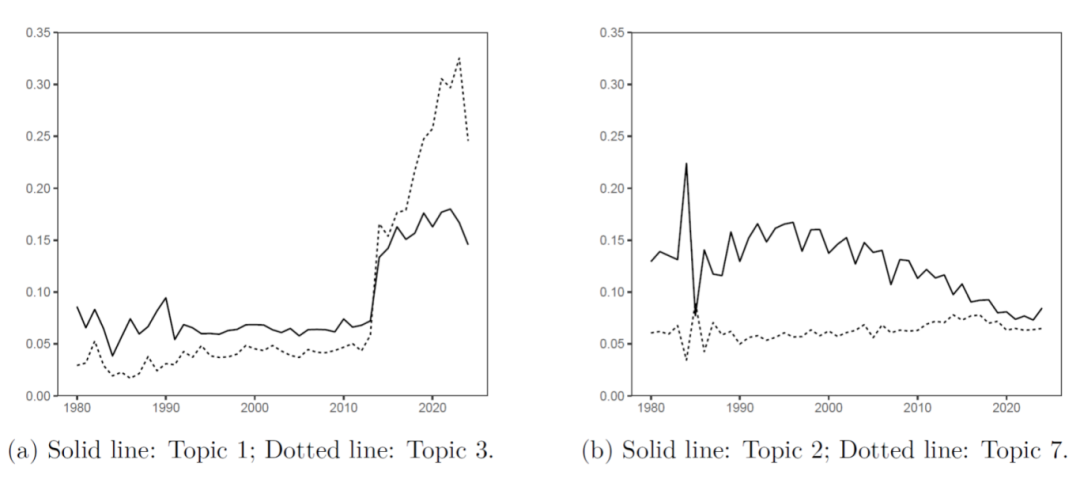

图4:(a)主题3(深度学习,实线)与主题1(算法与优化,虚线);(b)主题2(贝叶斯统计,实线)与主题7(无监督学习,虚线)

🚀 爆发式增长:主题3(深度学习主题)

深度学习主题在2010年之前几乎不存在于统计期刊中,但在纳入AI会议论文后(2010年开始),其占比呈现爆发式增长。到2020年代,深度学习已成为统计学讨论的核心议题之一。这反映了统计学对AI时代的积极回应——不是被动接受,而是主动为深度学习提供理论基础和可解释性工具。

📈 稳中有升:主题1(算法与优化)

算法与优化主题在统计期刊中一直保持稳定存在,但在加入会议论文后同样出现明显上升。这说明计算效率和优化算法在现代统计中的重要性与日俱增。

📉 相对下降:主题2(贝叶斯统计)

有趣的是,贝叶斯统计作为一个经典主题,其占比在过去40年呈现缓慢下降趋势。这并不意味着贝叶斯方法不重要了,而是反映了统计学研究焦点的多元化——新兴主题(如深度学习)的崛起分流了研究注意力。

🔃 稳定发展:主题7(无监督学习)

无监督学习主题在整个时期保持相对稳定的占比,显示出其作为基础研究方向的持久生命力。

4.4 主题含义变化

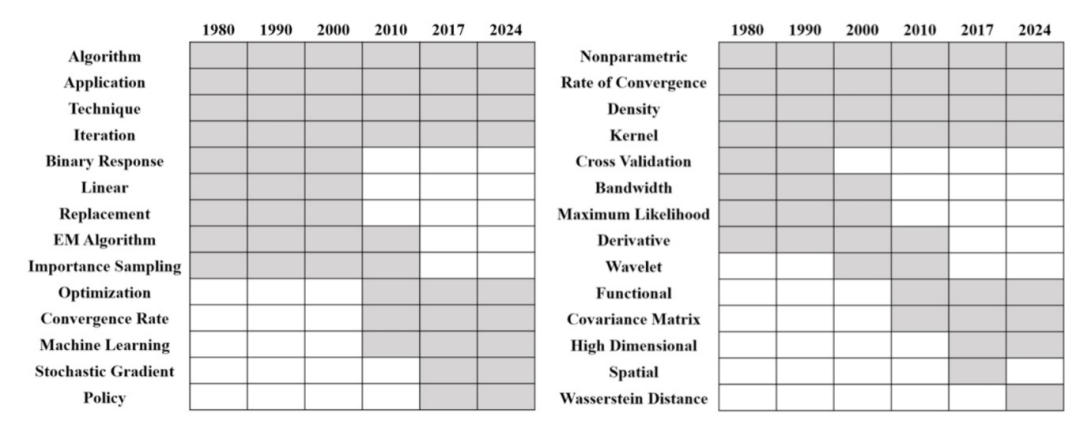

我们接下来讨论主题含义的变化,也就是每个主题下高概率词的动态变化。我们以“算法与优化”(主题1)和“非参数统计”(主题5)为例,展示了它们在不同时间段的高概率词。图5展示了它们在六个时间点(1980 年、1990 年、2000 年、2010 年、2017 年和 2024 年)的高概率词汇情况。

对于主题1(算法与优化),持续使用的词汇包括算法(Algorithm)、技术(Technique)以及相关概念。术语EM 算法(EM Algorithm)在 1980 年至 2000 年期间占据主导地位。然而,在 2010年代和 2020 年代,出现了像随机梯度(Stochastic gradient)、机器学习(machine learning)和策略(Policy)这样的词汇变化,这与深度学习和强化学习的进步相吻合。在最近的时期,优化成为了一个核心主题,反映了统计算法的日益复杂性以及对稳健优化策略的需求。

在主题5(非参数统计)中,诸如非参数(nonparametric)和收敛速率(rate of convergence)等术语清晰地表明了其对经典非参数理论的侧重。在 20 世纪 80 年代至 90 年代期间,诸如最大似然(maximum likelihood)、带宽(bandwidth)和交叉验证(cross validation)等主导术语与传统的非参数方法相契合。到 2000 年,小波(wavelet)一词成为关键术语。近几十年来,呈现出向高维方法(high dimensional)的转变趋势。值得注意的是,Wasserstein距离(Wasserstein distance)在 2024 年变得突出起来,它与深度学习中的生成模型以及分布回归等密切相关。

图5:主题1(算法与优化,左)和主题5(非参数统计,右)不同时段高频词(灰色为高频词)

对于第一节的问题(Q1),我们可以得到结论:统计学领域的演变呈现出明显的趋势,即从传统的理论领域转向了计算密集型和数据驱动的领域。像“深度学习”(主题3)这样的主题变得越来越重要,尤其是在 2010 年之后,而像“贝叶斯统计”(主题2)这样的传统领域则出现了相对的下降。图5中的词汇演变进一步证实了这一转变,突出了经典术语被机器学习和优化领域的概念所取代。

对于第一节的问题(Q2),我们可以得到结论:随着人工智能的兴起,统计学发生了显著的变化。这一点不仅体现在近年来“深度学习”(主题3)和“算法与优化”(主题1)等领域的广泛应用,还体现在经典主题的演变上。例如,“非参数统计”(主题5)已向人工智能领域转移,因为统计研究越来越多地针对新兴的人工智能概念进行非参数分析,例如分析神经网络ReLU激活函数的回归收敛、生成模型中的Wasserstein距离收敛等。这些趋势凸显了现代数据科学与统计研究的深度融合。

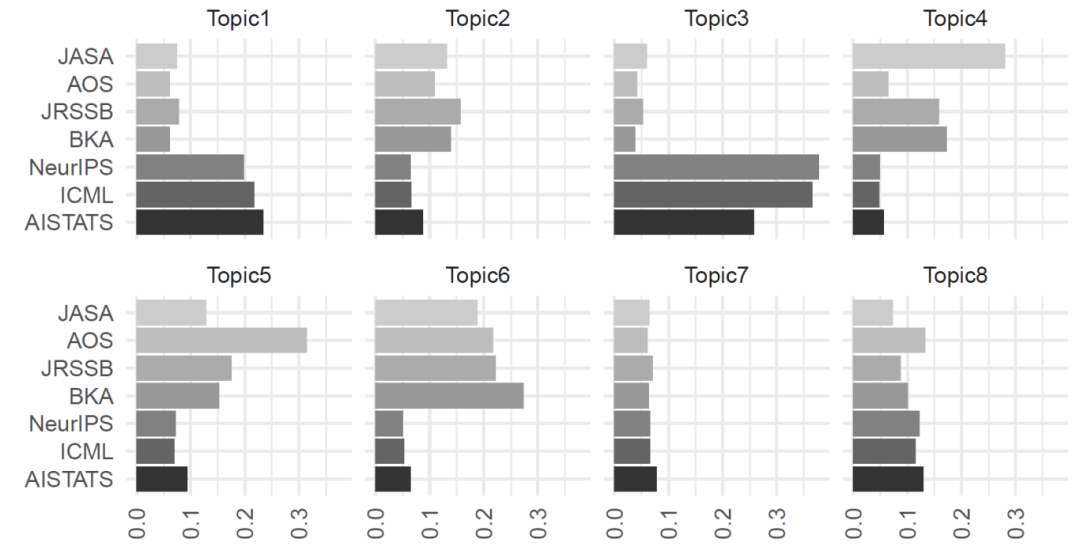

4.5 期刊偏好的差异

基于CDTM的模型结果,我们发现不同出版物对主题的偏好也存在显著差异,一些主要的结论如下:

➢ AOS: 更偏向理论性强的主题,如非参数统计(主题5)

➢ JASA: 更关注应用导向的主题,如回归分析(主题6)和生物统计(主题4)

➢ AI会议(NeurIPS/ICML/AISTATS): 毫无疑问地青睐算法优化(主题1)和深度学习(主题3)

图6:各主题下各个期刊/会议的占比(主题1:算法与优化;主题2:贝叶斯统计;主题3:深度学习;主题4:生物统计;主题5:非参数统计;主题6:回归分析;主题7:无监督学习;主题8:其他主题)

对于第一节的问题(Q3),我们可以得到结论:协变量在塑造研究趋势方面起着关键作用。发表的期刊对研究主题的流行程度有着重大影响,会议更倾向于计算相关主题,而期刊则侧重于理论基础。此外,作者的数量与诸如深度学习等应用性主题密切相关(主题3),这反映了现代数据科学研究的协作性质。

05

总结

从高引论文的变化到主题演变,一个清晰的信号是:统计学正在经历从“构建方法论”到“与AI共舞”的历史性转型。 统计学不仅在为深度学习提供理论支撑(如收敛性分析、泛化界),更在可解释性、因果推断、隐私保护等方面引领AI的发展方向。正如Lin et al.(2025)的观点:统计学不仅要回应AI的崛起,更要帮助塑造AI的发展。它提供了严谨性、可解释性和不确定性量化,这些正是黑箱模型最需要的。通过理解这些新兴趋势,我们能够更好地预判统计学研究的未来发展方向,并促进跨学科合作,以应对不断涌现的新挑战。

注:具体参考文献见文章原文。